Vattenmärkning avslöjar AI-texter

Behovet av att identifiera AI-genererat material har ökat kraftigt. Nu har forskare på Google Deepmind utvecklat en teknik som vattenmärker AI-skapad text.

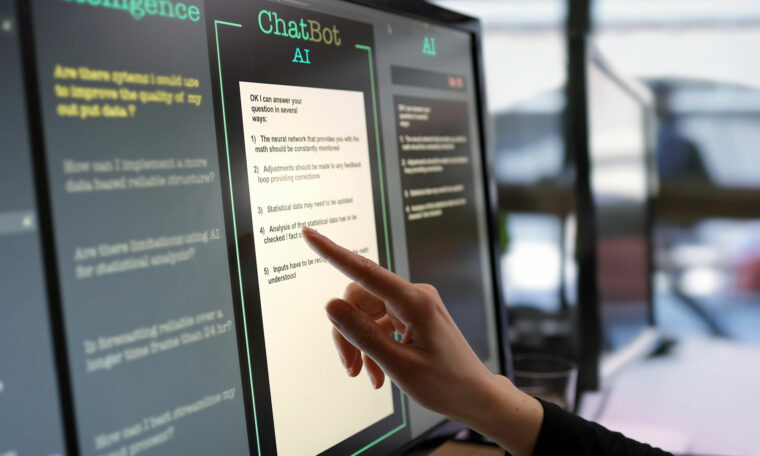

Testpersoner märkte inte någon skillnad mellan vattenmärkta och icke-vattenmärkta texter.

Bild: Getty images

Användningen av AI-genererat innehåll ökar snabbt i allt från automatiska nyhetssammanfattningar till mjukvaruutveckling. I takt med att modellerna blir mer sofistikerade blir det också svårare att avgöra om en text är skriven av en algoritm eller av en människa, något som möjliggör spridningen av desinformation i tidigare otänkbar skala.

Nu har forskare vid Google Deepmind utvecklat en ny metod kallad SynthID-Text som gör det möjligt att vattenmärka AI-genererade texter utan att påverka dess kvalitet eller hastighet. Tekniken implementerar osynliga vattenmärken direkt när texten genereras, vilket gör det möjligt att senare enkelt identifiera innehållets ursprung.

Google Deepmind uppmärksammades också nyligen då företagets Demis Hassabis och John Jumper fick Nobelpriset i kemi 2024 för AI-verktyget Alphafold som kan förutspå proteiners strukturer.

Märkningen döljs för läsaren

Tidigare metoder för att identifiera AI-genererad text har haft olika svagheter. Några har varit beroende av resurskrävande beräkningsprocesser eller visat sig ineffektiva på att känna igen texter som avviker från den data som modellen själv tränats på. Andra tekniker har likt SynthID-text försökt vattenmärka text, men det har då skett på bekostnad av textens kvalitet.

SynthID-text har tagit sig runt dessa problem genom att använda en så kallad statistisk signatur. Genom att justera sannolikheten för vilka ord som väljs under textgenereringen skapas subtila mönster som fungerar som ett dolt vattenmärke som är omöjligt för läsaren att upptäcka.

”På så vis inkorporerar SynthID-text omärkliga vattenmärken utan att kompromissa med modellens kvalitet, kreativitet eller hastighet”, säger Pushmet Kohli, en av forskarna bakom tekniken, i ett pressmeddelande.

Samma kvalitet med märkning

För att säkerställa att SynthID fungerar i praktiken genomförde forskarna ett omfattande test med över 20 miljoner AI-genererade texter. En del av dessa genererades med vattenmärken, andra inte. Sedan fick användarna av språkmodellen utvärdera de olika texternas kvalitet. Resultatet visade att testpersonerna inte märkte någon skillnad mellan vattenmärkta och icke-vattenmärkta texter.

Nu hoppas forskarna inspirera fler utvecklare.

”Utvecklare av andra AI-modeller kommer nu enklare kunna identifiera om texter härstammar från deras egna system, vilket gör det enklare att i framtiden bygga ansvarsfulla AI-modeller”, säger Pushmeet Kohli i pressmeddelandet.