Bild: Getty images (montage)

AI med rätt att döda

AI marscherar in på slagfältet, men ska AI-styrda vapen ha rätt att döda? Nu vill allt fler se ett förbud mot dödliga autonoma vapensystem.

Världens alla bin håller på att dö ut. För att pollinera insekter har företaget Granular utvecklat artificiella bin i form av små drönare. Men drönarbina hackas. Deras bildigenkänningsalgoritmer programmeras om från att känna igen blommor till ansikten. I svärmar söker de upp och dödar utvalda människor som använt en hotfull hashtagg på sociala medier.

Scenerna utspelas i ett avsnitt av science fiction-serien Black mirror. Nu oroas allt fler över att den snabba utvecklingen av AI och robotik gör att liknande svärmar av ”mördarrobotar” kan bli verklighet och att de i en dystopisk framtid programmeras för att döda personer, baserat på kön, ålder eller på vilken folkgrupp de tillhör.

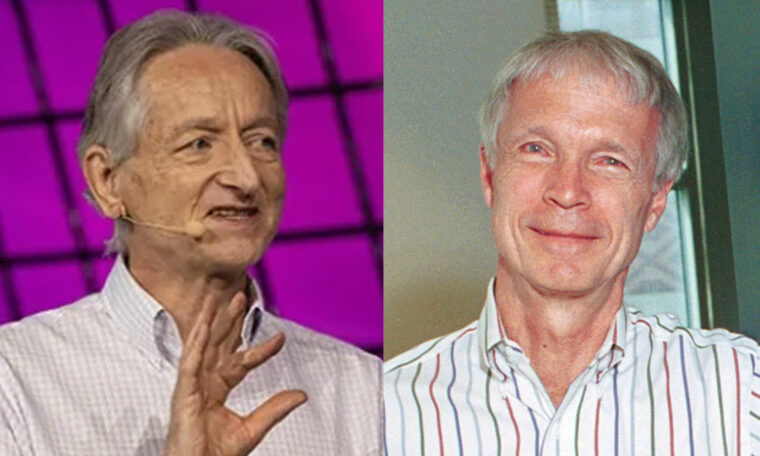

AI-pionjär varnar för utvecklingen

En av dem som länge varnat för utvecklingen och propagerat för ett förbud mot vapen som dödar utan mänsklig kontroll är AI-pionjären Stuart Russell. I en artikel i tidskriften Nature 2023 pekar han på en accelererande trend mot allt smartare vapen och att upprustningen till följd av det oroliga världsläget gör att mördarrobotar kan bli vardag inom en nära framtid om ingenting görs.

Han är inte ensam om sin oro. Det finns en stark opinion mot att släppa kontrollen över liv och död till algoritmer. Människorättsorganisationer som Human rights watch har länge propagerat för ett förbud. Kampanjen ”Stop killer robots” stöttas av mer än 180 internationella, regionala och nationella, icke-statliga organisationer.

Många robot- och AI-forskare vill inte heller se att tekniken de utvecklar används för att döda. Närmare 5 000 forskare inom fältet har hittills skrivit på ett öppet brev med krav på förbud mot ”offensiva autonoma vapen bortom meningsfull mänsklig kontroll”. Bakom brevet står organisationen Future of life institute, som även gjort uppmärksammade filmer som visar hur svärmar av tusentals små drönare dödar utvalda grupper, inte olikt scenerna i Black Mirror.

Diskussioner om huruvida det behövs en komplettering av folkrätten för dödliga autonoma vapensystem pågår sedan 2014 i Genève. Inom ramen för 1980 års vapenkonvention samlas regelbundet en expertgrupp kring frågan. Men arbetet går trögt. Ryssland och USA samt en del andra länder är emot en reglering, och eftersom ett beslut kräver konsensus finns ännu inga förslag på bordet.

FN hoppas på enat förbud

I början av november 2023 röstade FN:s generalförsamling i New York för första gången igenom en resolution gällande autonoma vapen, och FN-chefen António Guterres har uppmanat världens länder att enas om ett förbud till 2026.

Bild: Sipri

– Initiativen som nu tagits av FN i New York visar att en del aktörer börjar bli otåliga och inte längre tror att diskussionen i Genève kommer att leda fram till något, säger Vincent Boulanin, programchef för reglering av AI på Stockholms internationella fredsforskningsinstitut, Sipri.

Han forskar bland annat om hur den nuvarande folkrätten kan appliceras på ”dödliga autonoma vapensystem” (lethal autonomous weapon systems, LAWS), som är den beteckning som bland annat FN använder.

– Det finns inget juridiskt vakuum. Krigets lagar gäller för alla typer av vapen, inklusive autonoma vapensystem. Problemet är att den nuvarande rätten kan tolkas på olika sätt. Vissa länder är kanske mycket mer liberala än andra, och där det finns otydligheter finns ett värde av att komma överens om nya regler eller principer, säger Vincent Boulanin.

En stötesten är att definiera vad som egentligen menas med ”dödliga autonoma vapensystem”. En definition som ofta används lyder ”vapen som när de aktiverats kan identifiera och välja ut mål och applicera kraft på dem utan mänsklig intervention”.

Hur mycket ”mänsklig intervention” som krävs för att vapnet inte ska räknas som autonomt råder det dock delade meningar om. En annan fråga handlar om ansvar. Om en maskin programmeras för att döda motståndare, men av misstag dödar civila – vem ska ställas till svars?

– Maskiner kan inte hållas ansvariga, utan det är i slutänden de stater som använder systemen som är ansvariga. Vi säger ofta att maskiner fattar beslut men det är ett antropomorfiskt sätt att beskriva vad maskinen gör. De fattar inte beslut som vi, utan de väljer bland förprogrammerade alternativ, säger Vincent Boulanin.

Kapprustning om AI i krigföring

Om processen mot en eventuell reglering går långsamt så går utvecklingen desto snabbare. Med hjälp av AI utvecklas allt från smarta krigslednings- och övervakningssystem till autonoma u-båtar. USA och Kina går i täten. Båda stormakterna vill få ett övertag på framtidens slagfält.

Bild: Marie Alpman

– AI kommer att reformera sättet att bedriva krig på. Kapprustningen mellan USA och Kina gäller vem som blir först med att få till en fungerande integration av AI i krigföringen, säger Peter Bovet Emanuel, överstelöjtnant som forskar på Försvarshögskolan om vad AI betyder för framtidens krigföring.

Precis som i samhället i övrigt används AI redan i många militära sammanhang, till exempel för att tolka satellitbilder. Gradvis kommer AI-system även att användas för mer avancerade uppgifter. Peter Bovet Emanuel ser till exempel hur AI-modeller blir allt viktigare som beslutsstöd.

– I en värld med allt mer information har den mänskliga hjärnan svårt att hänga med. Här kan AI hjälpa till att snabbt analysera stora mängder data och fungera som rådgivare i militära staber på alla ledningsnivåer, säger han.

Andra uppgifter för AI är att planera logistik och underhåll eller simulera olika scenarier. Autonoma drönare kan söka efter försvunna och skadade. Själv utvecklar Peter Bovet Emanuel två olika AI-modeller för beslutsstöd, varav den ena bygger på djupinlärning med uppgift att hitta eldledningsradar för luftvärnsrobotsystem. Modellen har tränats upp på stora mängder satellitbilder och ”lärt sig förstå” hur topografisk information påverkar utbredning av radarsignaler.

– Modellen pekar ut de bästa platserna för att placera ett radarsystem. Informationen kan sedan användas för att lokalisera och attackera dessa mål, förklarar Peter Bovet Emanuel.

Ökar det fysiska avståndet till fienden

Inom krigföringen har det länge funnits en strävan mot en högre grad av automatisering som ökar avståndet till fienden. I en Sipri-rapport från 2017 listas ett 50-tal exempel på system som kan spana, upptäcka och i vissa fall attackera mål på egen hand. Det handlar framför allt om försvarssystem som ska skydda fartyg, stridsvagnar eller militära anläggningar mot robotar och missiler från luften. Men det finns också exempel på mer offensiva vapen i form av så kallade ”kamikazedrönare” som kan cirkla länge i luften och spana efter mål som de sedan attackerar genom att krascha in i dem.

Peter Bovet Emanuel tror att de militära systemen gradvis kommer att fortsätta att utvecklas mot allt större autonomi, och att det blir svårt att sätta stopp för utvecklingen.

Bild: Darpa

– Stater har helt enkelt inte råd att riskera att inte klara en överraskningsattack, och då krävs alltmer autonoma försvarssystem. Sedan är steget rätt kort till att börja använda dem även för offensiva syften. Här är det viktigt med en bred diskussion kring vad som är etiskt försvarbart och att reglera användningen av tekniken, snarare än att försöka begränsa teknikutvecklingen i sig.

Ett av argumenten mot vapen som dödar utan ”meningsfull mänsklig kontroll” är att maskiner saknar moral och den etiska kompass som behövs för att fatta komplexa beslut i en krigssituation. Ett annat är att de fattar så snabba beslut att människor har svårt att hänga med, vilket kan leda till en onödig eskalering av en konflikt.

Användningen kommer inte heller att begränsas till krig. Om den här typen av vapen utvecklas och marknadsförs kan de även utnyttjas av terrorister och kriminella. Även polisen kan komma att anamma tekniken. När vapen blir mer och mer beroende av programvara ökar också risken för att de hackas.

Motargument som ofta framförs är att människor blir trötta, stressade och traumatiserade och att robotar mer exakt kan skilja på stridande och civila. De kommer heller aldrig att fatta egna beslut, utan följa de instruktioner som de programmerats för.

Än finns bara ett fåtal kända exempel på automatiserade vapen som även utvecklats för att döda. Sydkorea har utvecklat robotvapen för övervakning av den demilitariserade zonen mot Nordkorea. Den enda dokumenterade användningen av den här sortens vapen skedde vid en attack i Libyen 2020. Enligt en FN-rapport användes där en drönare, tillverkad av ett turkiskt företag, försedd med bildigenkänning för att hitta och attackera mänskliga mål.

Tekniken för att bygga ”mördarrobotar” är numera lätt att få tag i. Vem som helst kan köpa en drönare med AI, kameror och andra avancerade sensorer för några tusenlappar. Drönarna kan förses med vapen och programmeras för att på egen hand ta sig från A till B.

Bild: Saab

Drönare spanar i Ukraina

Kriget i Ukraina har blivit något av ett levande labb för billiga hobbydrönare som kan byggas om för spaningsuppdrag och attacker. Detta följs noga av både försvarsmakter och försvarsföretag. För dessa organisationer, vana vid stora och dyra vapensystem, innebär utvecklingen mot små och billiga drönare en stor förändring där det gäller att hänga med.

Enligt en uppskattning från Georgetown university investerar den kinesiska militären mer än 16 miljarder kronor årligen på AI. Även USA:s militär storsatsar. Ett av de senaste initiativen är programmet ”replicator” som går ut på att utveckla tusentals små och billiga autonoma drönare och andra farkoster inom de närmaste två åren. Nato har inrättat en ny innovationsfond som ska investera en miljard euro i nya företag, som utvecklar ”banbrytande” teknik inom bland annat AI och autonoma drönare och andra typer av farkoster.

Även den svenska försvarskoncernen Saab ser möjligheterna och köpte i höstas upp två mindre AI-företag. Det ena, Bluebear, är baserat i Storbritannien och utvecklar autonoma drönare som kan samarbeta i flock.

Bild: Marie Alpman

– Det är en väldigt het teknologi där vi vill vara med och ligga i framkant, säger Petter Bedoire, teknik- och forskningschef på Saab.

Gör det svårare att gömma sig

Den snabba utveckling som skett av AI under de senaste åren är på väg att förändra krigföringen. Enligt Petter Bedoire kommer det bli allt svårare att gömma sig. Från satellit- och radarbilder fås en ständigt uppdaterad bild av allt som rör sig. Det andra företaget som Saab köpt upp, amerikanska Crowd AI, specialiserar sig på avancerad bildigen-känning som snabbt kan skilja till exempel på civila och militära fordon.

När det gäller drönarsvärmar krävs mer utveckling innan Saab kan börja sälja sådana system, förklarar han.

– Traditionellt har vi byggt system som är väldigt regelbaserade, men beteendet hos de här nya systemen, som bygger på maskininlärning, är svårare att förutse. Viktiga frågor är om vi kan lita på att de förstått sin uppgift och att de kan fullgöra den.

En av uppgifterna han ser framför sig är spaning. En flock av samarbetande drönare kan skickas ut för att kartlägga både de egna och motståndarnas styrkor på ett stridsfält.

– Befälhavarna kan då få en mycket bättre överblick, utan att det behövs en person som styr. De kan också hjälpa till med att frakta saker fram och tillbaka från fronten.

Men om drönarna förses med vapen och det börjar handla om liv och död, då måste det vara en människa som styr, poängterar Petter Bedoire. Han tycker det är bra att det förs en debatt om risker med ”mördarrobotar” och Saab följer noga frågor om etik och lagstiftning.

Bild: Sameer Al-Doumy / Getty Images

– Samtidigt kan det finnas länder som inte tar lika stor hänsyn till den typen av överväganden. På stridsfältet kan vi då komma att möta drönarsvärmar och då måste vi kunna skydda oss. Vi kan behöva drönarsvärmar för att försvara oss mot drönarsvärmar.

I Ukraina fortsätter drönarattackerna. Än så länge styrs de av piloter på distans, men ett allt större problem är att radiosignalerna störs ut av motståndaren, så kallad jamming. Piloten tappar då kontrollen. Båda sidor försöker nu överlista varandra med smarta motmedel.

En risk är dock, menar bland annat Stuart Russell, att detta även riskerar att driva fram en allt större autonomi, som gör att drönarna kan hitta sina mål utan hjälp av signaler från piloten, med andra ord utan meningsfull mänsklig kontroll.

Prenumerera på Forskning & Framsteg!

10 tidningsnummer om året och dagliga nyheter på fof.se med kunskap baserad på vetenskap.