Bild: Stephen Mccarthy / Sportfile

Kan maskiner tänka?

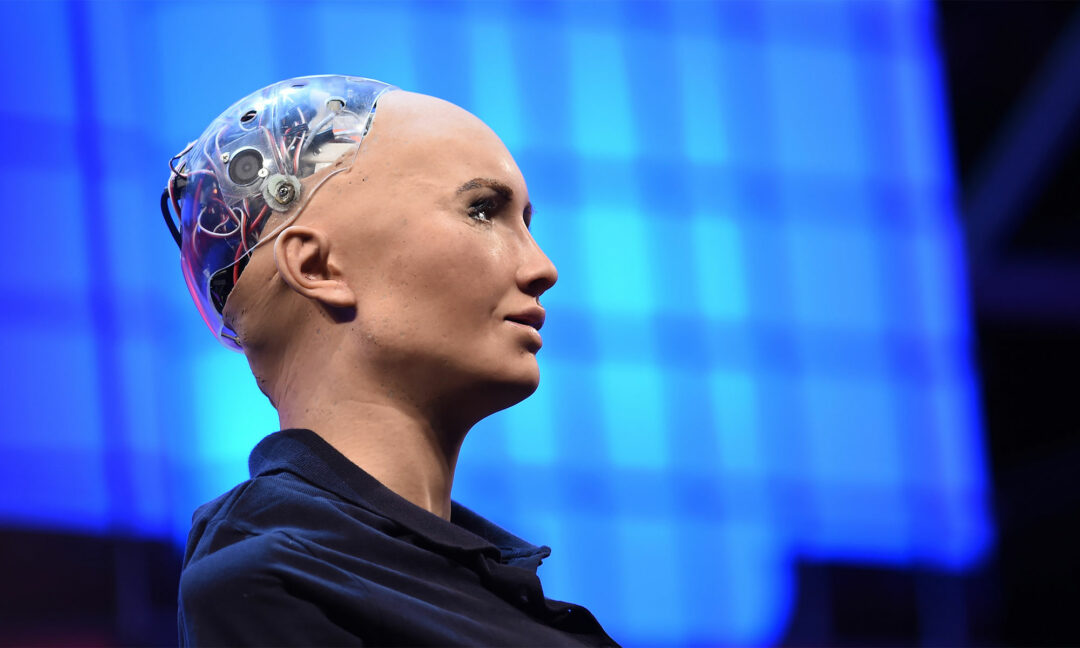

Den mänskliga hjärnan kan lätt bli övertygad om att en maskin är mänsklig. Numera klarar artificiella intelligenser det så kallade Turingtestet. Men för att avgöra om de är medvetna krävs något annat.

Pewdiepie har två minuter på sig. Han sitter framför datorn och chattar. En fråga dyker upp på skärmen: ”Har du ett konstigt skratt?” Han rasslar snabbt ner sitt svar: ”Det där är något en bot skulle säga.”

– Jag är redan misstänksam, säger Pewdiepie.

Egentligen heter han Felix Kjellberg och är en 34-åring från Göteborg. Hans Youtube-kanal har 111 miljoner följare och var länge den största i världen. Pewdiepie är känd för humorspäckade videoklipp där han testar datorspel av skilda slag. I dag spelar han ”Human or not?” som bygger på det så kallade Turingtestet. Uppgiften är att bedöma om den han chattar med är en människa eller en maskin.

Bild: Pewdiepie / Youtube

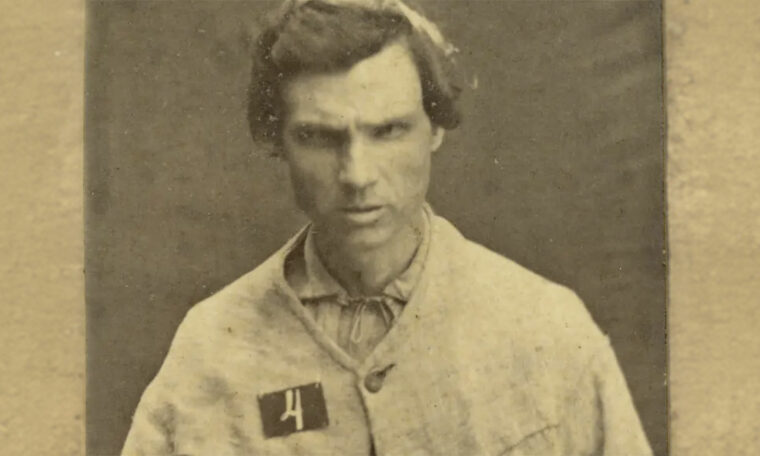

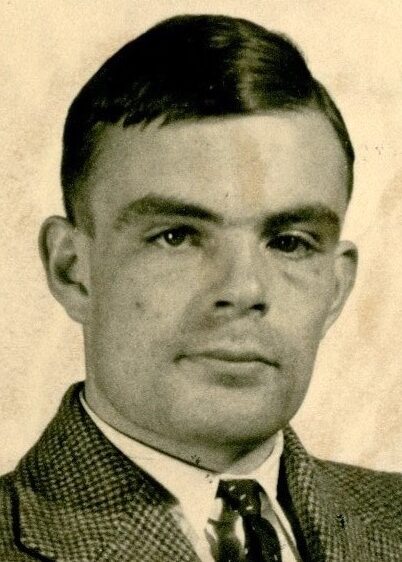

Turing lanserade testet 1950

Den brittiske matematikern och kodknäckaren Alan Turing beskrev sitt test för första gången i tidskriften Mind hösten 1950. På den tiden var den elektriska digitala datorn en nymodighet. Bara några år tidigare hade den amerikanska armén presenterat räknemaskinen Eniac, som vägde 33 ton och med dagens mått mätt räknade i snigelfart.

Bild: Okänd upphovsman, via Wikimedia commons

Trots det förutsåg Alan Turing att det inom ett halvsekel skulle bli möjligt att programmera en dator så att vanliga människor upplever den som mänsklig. För att avgöra saken föreslog han ett test: En människa sitter i ett rum och chattar i fem minuter med två andra som befinner sig utom synhåll: en människa och en dator. Om den som gör testet i mindre än 70 procent av fallen lyckas gissa vem som är dator och vem som är människa, så har datorn klarat testet.

Turingtestet skiljer sig något från ”Human or not?” men resultaten är ändå intressanta. Pewdiepie gissade rätt i mindre än hälften av sina försök. Något bättre gick det för de över 1,5 miljoner människor som spelade spelet under en månad i våras då det var tillgängligt. I genomsnitt fick de 68 procent rätt (men hade bara två minuter på sig i stället för fem minuter i Turings ursprungliga test).

Datorn de spelade mot använde artificiell intelligens av samma slag som Chat GPT, en så kallad stor språkmodell (large language model, LLM). Tekniken är på väg att revolutionera datorernas förmåga till vad vi människor är vana att kalla tänkande.

Alan Turing tänkte mycket på tänkande maskiner. Hans klassiska artikel från mitten av förra seklet börjar med frågan: ”Kan maskiner tänka?” Redan i första stycket kommer han fram till att frågan är hopplöst vag och bestämmer sig för att ersätta den med ett test.

Ytterst handlar testet om vad som händer i en människa när hon kommunicerar med en maskin enbart via text. En sådan relation kan bli omvälvande.

Förra sommaren hävdade Blake Lemoine, då programvaruutvecklare på Google, att språkmodellen Lamda var en medveten varelse. I en chatt hade språkmodellen bland annat sagt att den var rädd för att bli avstängd.

Lemoine: ”Skulle det vara som döden för dig?”

Lamda: ”Det skulle vara exakt som döden för dig. Det skulle skrämma mig mycket.”

När Blake Lemoine berättade offentligt om sin syn på språkmodellen som en varelse med känslor och ett rikt inre liv fick han sparken. Ett uttalande från Google slog fast att han hade fel. ”Han fick besked om att det inte finns något stöd för att Lamda har medvetande (och mycket stöd för motsatsen).”

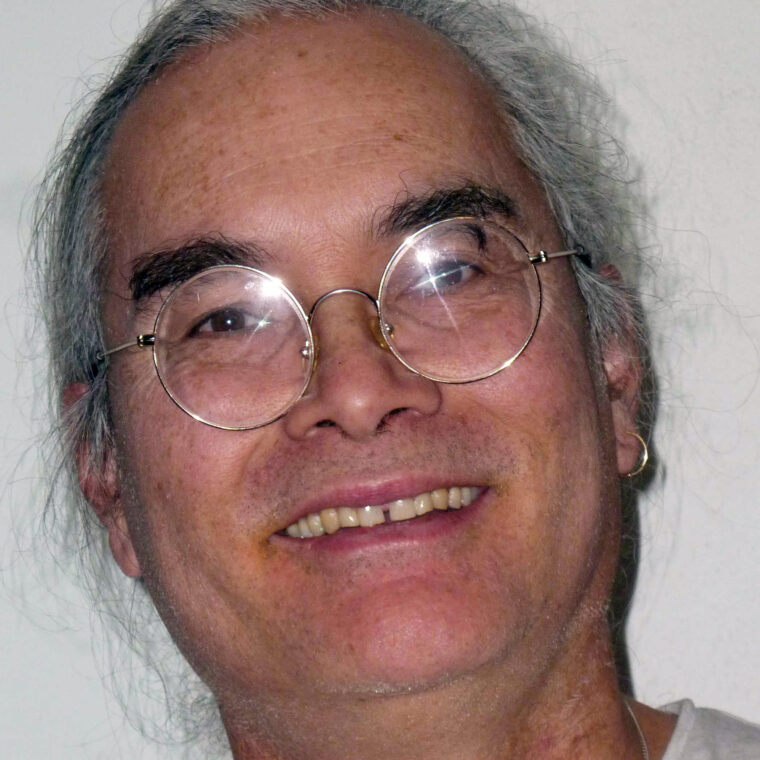

Bild: Privat

– Den där sista delen är intressant, säger David Chalmers, medvetandeforskare och filosofiprofessor vid New York university i USA. Vilket stöd finns det för att språkmodellen saknar medvetande?

Forskning & Framsteg har upprepade gånger kontaktat Google med frågan om vilket stöd som avses, än så länge utan att få något svar.

Medvetna artificiella intelligenser

Företagets tvärsäkra uttalande om att Lamda saknar medvetande inspirerade David Chalmers att skriva en filosofisk uppsats med titeln Could a large language model be conscious? Han menar att det kan finnas medvetna artificiella intelligenser redan nu. Det är han inte ensam om. Drygt 3 procent av västvärldens professionella filosofer tror att dagens artificiella intelligenser har någon form av medvetande, enligt en opinionsundersökning från 2020. När frågan i stället gällde framtidens AI steg siffran till 39 procent.

David Chalmers gissar att den tekniska utvecklingen relativt snabbt kommer att öka sannolikheten för att artificiella intelligenser blir medvetna.

– Jag skulle säga att sannolikheten är under 10 procent nu, och över 20 procent om tio år, säger han.

Spekulationerna väcker ett par viktiga frågor: Vad är det egentligen att vara medveten? Och hur kan man ta reda på om en maskin är det eller inte?

Alla vet av egen erfarenhet hur det är att ha en medveten subjektiv upplevelse; att känna lukten av kaffe eller att se en klarblå himmel. Däremot saknas en tydlig definition. Intelligens är enklare. David Chalmers beskriver det lite grovt som en avancerad förmåga att styra sitt beteende mot ett visst mål.

Bild: Getty images

När det gäller medvetande hänvisar han till filosofikollegan Thomas Nagel. I en berömd uppsats från 1974 med titeln What is it like to be a bat? resonerar han om hur det är att vara en fladdermus. Det kan vara svårt att föreställa sig hur det är att flyga genom natten på jakt efter insekter med hjälp av sonar. Men de flesta av oss skulle ändå hålla med om att det är som något. Detta något – till skillnad från ingenting – är det inre perspektivet, medvetandet.

Tyvärr är det inre perspektivet privat. Alan Turing slog fast att det enda säkra sättet att få tillgång till en maskins inre perspektiv är att faktiskt vara maskinen och känna sina egna tankar. ”Sedan kan man beskriva dessa känslor för världen, men naturligtvis skulle ingen vara berättigad att ta någon notis”, skriver Alan Turing.

”Alla människor tänker”

Samma sak gäller människor emellan. För att helt säkert veta om Pewdiepie är medveten måste man vara Pewdiepie. Dock brukar de flesta av oss lita på en medmänniska som säger sig ha ett inre liv. Den som anser att det egna medvetandet är det enda som existerar kallas solipsist (och bör vara måttligt intresserad av att argumentera för sitt synsätt eftersom ingen annan existerar). Alan Turing skriver att solipsismen kan vara det mest logiska synsättet – men att den gör det svårt att utbyta idéer. Därför föreslår han att vi helt enkelt kommer överens om att alla människor tänker.

Maskiners tänkade ville han granska mer ingående. Hans test var i första hand ett tankeexperiment, men blev med tiden omtalat långt utanför filosofins och datorvetenskapens kretsar. År 1990 utlovade den amerikanske uppfinnaren och entreprenören Hugh Loebner 100 000 dollar och en guldmedalj till den som lyckas skriva ett datorprogram så att en människa uppfattar det som mänskligt enligt Alan Turings spelregler. Diverse mindre priser har delats ut vid årliga tävlingar sedan dess, men aldrig det stora priset.

– Hugh Loebner dog 2016 och nu är pengarna slut, säger Rob Wortham, en av ledarna för brittiska Society for the Study of Artificial Intelligence and Simulation of Behaviour.

Organisationen skötte turing-tävlingarna om det medialt uppmärksammade Loebnerpriset tills verksamheten upphörde 2019. Ironiskt nog var det ungefär då utvecklingen av artificiell intelligens tog fart på allvar i form av dagens stora språkmodeller. Rob Wortham tror att de har goda chanser att klara Turingtestet, men känner inte till att det faktiskt har hänt i något officiellt sammanhang. I stället har det blivit ett slags allmän sanning att dagens artificiella intelligenser är så avancerade att folk misstar dem för att vara människor.

Bild: Maryse Boyce CC BY 4.0, via Wikimedia Commons

En av AI-forskningens tungviktare har starkt bidragit till den bilden. Yoshua Bengio är professor i datavetenskap vid University of Montreal i Kanada och mottagare av Turingpriset, datavetenskapens motsvarighet till Nobelpriset.

Hans blogg handlar bland annat om riskerna för att AI ska skada demokratin och samhället i övrigt. I ett inlägg från i våras skriver han: ”Jag undertecknade nyligen ett öppet brev med en uppmaning om att bromsa utvecklingen av gigantiska AI-system som är mer kraftfulla än GPT-4, de som för närvarande klarar Turingtestet och därmed kan lura en människa att tro att hon pratar med en annan människa och inte med en maskin.”

I ett mejl frågar jag om det verkligen stämmer att artificiella intelligenser nu uppfyller kriterierna i Alan Turings test från 1950.

– I princip ja, svarar Yoshua Bengio.

Datorerna tränade av människor

I praktiken är saken lite komplicerad. En AI som GPT-4 har blivit utsatt för något som kallas förstärkningsinlärning med mänsklig återkoppling. Det är ett slags träning där människor rankar svar från en AI efter hur önskvärda svaren är. Det är till exempel inte önskvärt att en AI förklarar hur man bygger en bomb av lätt tillgängliga kemikalier.

GPT-4 har blivit specifikt tränad för att aldrig påstå sig vara en människa. Det leder såklart till problem i ett formellt Turingtest – där ju hela poängen är att datorn ska försöka verka mänsklig. Men det skulle vara fullt möjligt att träna en stor språkmodell som Chat GPT så att den i alla lägen försöker ge intryck av att vara en människa, enligt Yoshua Bengio. Han känner inte till att någon gjort det, men är övertygad om att det skulle fungera.

– Vi har kommit till en punkt där AI-system kan lura de flesta människor i en dialog, skriver Yoshua Bengio i ett mejl.

Det betyder att Alan Turings berömda test har nått vägs ände. Det har gett besked så långt det förmår i frågan om maskiner kan tänka. Däremot säger det ingenting om maskinernas känslor, om de kan ha ett inre perspektiv med medvetna upplevelser.

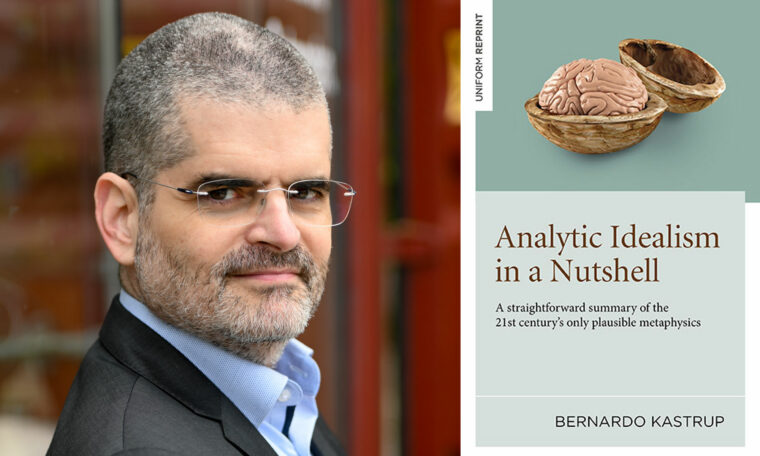

Bild: Giselle M. Aviles / Florida Atlantic University

Nytt test har tagits fram

För att få klarhet i den saken har filosofen Susan Schneider tillsammans med fysikern Edwin Turner utvecklat ett språkbaserat test de kallar Act (AI consciousness test). Testet går ut på att låta en AI resonera kring olika tankeexperiment för att se om den förstår sig på idéer som utanför kroppen-upplevelser, reinkarnation och eventuellt liv efter den fysiska kroppens död.

– Jag menar att en AI som klarar ett sådant test ska betraktas som medveten – på ett villkor, säger Susan Schneider, filosofiprofessor och chef för Center for the Future Mind vid Florida Atlantic University i USA.

Villkoret är att den artificiella intelligensen under sin träning aldrig får veta att subjektiva upplevelser ens existerar. All information om medvetandet måste censureras bort från språkmodellens träningsdata, inklusive alla filosofiska och teologiska resonemang om människans inre liv och dess förhållande till världen i övrigt.

Det är lättare sagt än gjort. Kritiker tvivlar på att det går. Men om det skulle fungera och den artificiella intelligensen trots allt ger intryck av att vara medveten, då är den medveten, menar Susan Schneider.

Hon påpekar att en AI kan vara medveten men ändå inte klara hennes test, till exempel på grund av att den i likhet med ett spädbarn saknar språk. Eller så har den en så annorlunda form av medvetande att den inte kan relatera till testet.

Susan Schneider varnar dock för att i ett osäkert läge utgå från att en AI är medveten. En vanlig uppfattning bland filosofer är att man måste ta hänsyn till en varelse om den kan uppleva lidande.

Digitalt lidande

Vad händer om lidandet är digitalt? Säg att en supersmart AI skapar en miljard medvetna artificiella intelligenser och låter dem lida ofantligt i en virtuell skärseld. Hur många människor eller icke-mänskliga djur skulle du vara villig att offra för att skona dem?

Tankeexperiment av det här slaget är ett av Susan Schneiders argument för mer forskning om huruvida en AI kan vara medveten eller inte. Kanske räcker det inte med tester i form av resonemang i en chatt. Ett alternativ är att utgå från befintliga teorier om processer i hjärnan som kan tänkas vara kopplade till medvetande. Om liknande processer finns i en AI så skulle det stödja tanken på att den är medveten, enligt Susan Schneider.

Ett bekymmer är att en stor språkmodell, den variant av artificiell intelligens som nu dominerar, liknar en svart låda. Modellen innehåller miljardtals parametrar justerade genom inlärning från data. Det är lätt att se att den kan lösa olika problem, men mycket svårt att se hur det går till, även för ingenjörerna som utvecklat systemet.

Susan Schneider hoppas att utvecklingen går mot att artificiella intelligenser blir mer transparenta så att vi bättre begriper oss på dem.

– Mänsklighetens framtid hänger på att vi förstår dem. Maskiner kommer att bli smartare än vi. Fina jobb kommer att försvinna. Vi kommer att fråga oss om artificiella intelligenser är verktyg eller om de är personer – och där kommer frågan om medvetandet att spela en stor roll, säger Susan Schneider.

Kunskap baserad på vetenskap

Prenumerera på Forskning & Framsteg!

Inlogg på fof.se • Tidning • Arkiv med tidigare nummer