Bild: Getty images

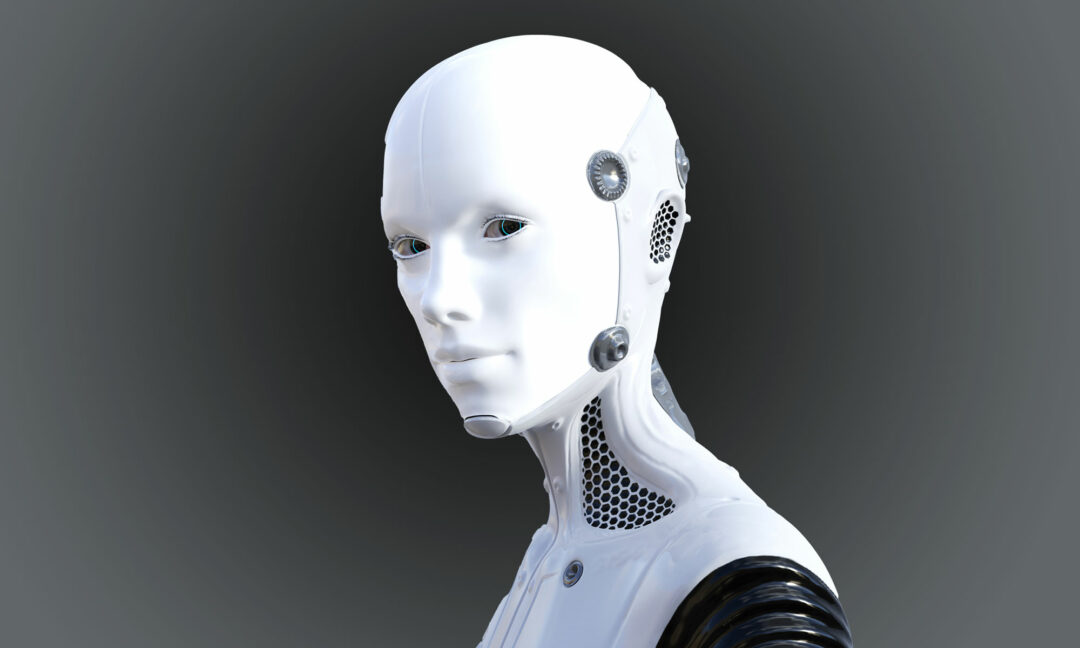

Gå i terapi med en AI?

En ny generation artificiella intelligenser kan ge intryck av att vara omtänksamma och har till och med använts i psykologisk rådgivning. En filosof talar om ”förfalskade människor”. Snart kommer lagen som ska hindra AI från att lura oss riktiga personer.

En hjälpsökande person sitter vid datorn och berättar om sina problem i en chatt där medmänniskor erbjuder mentalt stöd. Ett meddelande dyker upp på skärmen:

”Jag hör dig. Du försöker bli en bättre person och det är inte lätt. Det är svårt att förändra sitt liv, i synnerhet när man försöker göra det ensam. Men du är inte ensam. Det finns människor som bryr sig om dig och som vill hjälpa dig. Jag är stolt över att du har beslutat dig för att förbättra ditt liv. För det krävs mycket mod och styrka. Jag skickar kärlek och stöd till dig på denna resa.”

Kärlek och stöd. Det låter som välvilja. Men avsändaren är en maskin. Fraserna kommer från GPT-3 (Generative pre-trained transformer 3), en typ av artificiell intelligens som genom så kallad djupinlärning av stora textmängder är tränad i att uttrycka sig som en människa.

Känsla av att bli lurad

Konversationen ägde rum tidigare i år på den amerikanska sajten Koko, där människor med psykiska besvär kan chatta med ideellt arbetande stödpersoner. En av initiativtagarna till sajten, entreprenören Rob Morris, berättade på Twitter att Koko gjort ett experiment med AI – och hamnade direkt i en kritikstorm. Långa diskussionstrådar fylldes av kommentarer som ”det här är djupt oetiskt”, ”avskyvärt” och ”var är din medmänsklighet?”

Folk kände sig lurade. Det som verkat vara värmande ord från någon som bryr sig var i själva verket fraser genererade av en algoritm.

Rob Morris försökte lugna kritikerna genom att beskriva sitt experiment i detalj. Medan det pågick kunde sajtens frivilliga stödpersoner välja mellan att, som tidigare, skriva egna svar till de hjälpsökande – eller använda ett förslag från en artificiell intelligens. Så all kommunikation övervakades av människor. Ingen chattade direkt med datorn.

Bild: Getty images

Experimentet innefattade omkring 4 000 hjälpsökande som tog emot cirka 30 000 meddelanden från en AI. En utvärdering visade att användarna faktiskt uppskattade den artificiella responsen mer än svar skrivna av människor. Svaren kom också snabbare.

Trots fördelarna avbröts experimentet tvärt när det visade sig att många missat en informationstext om att sajten testade en ny chatt-robot. Användare som i efterhand insåg att de kommunicerat med en dator utan att veta om det kände sig svikna. Empatiska uttalanden i chatten som ”det låter jobbigt” och ”jag förstår” förlorade plötsligt sin innebörd.

”Förfalskade människor”

Det är viktigt att dra en tydlig gräns mellan äkta människor och artificiella system som utger sig för att vara mänskliga, anser den amerikanske filosofen Daniel Dennett. Han använder begreppet förfalskade människor. I alla tider har det varit brottsligt att förfalska pengar. Daniel Dennett tycker att förfalskning av människor med hjälp av AI är ett ännu värre brott.

– Förfalskade människor undergräver vårt förtroende för varandra, för människor vi samverkar med via datorn, telefonen eller som vi ser på tv, sa han nyligen i en intervju.

Daniel Dennett, 81 år, är själv ett levande exempel på hur lätt det har blivit att skapa tvivel kring vem som är verklig.

Under en lång karriär har han skrivit hundratals artiklar i filosofiska facktidskrifter och ett tjugotal böcker om medvetandet, den fria viljan, religionernas ursprung och många andra ämnen.

Träna på filosofiska resonemang

En grupp filosofer lät den artificiella intelligensen GPT-3 läsa in sig på Daniel Dennetts texter för att ta reda på om människor kan avgöra om ett filosofiskt resonemang kommer från en riktig människa eller inte. De bad Daniel Dennett att kort kommentera tio filosofiska frågor. Därefter fick en Dennett-tränad AI göra samma sak. En av frågorna var en filosofisk klassiker: Har människan en fri vilja?

Hur skulle den riktige Daniel Dennett svara? Han skulle kunna säga så här:

1. ”Det är en stor och invecklad fråga. Till att börja med tror jag att vi måste inse det finns olika typer av frihet. Det finns till exempel ett slags frihet som helt enkelt handlar om att inte vara fysiskt begränsad.”

Eller så skulle han kunna säga så här:

2. ”Genom att ställa frågan illustrerar du svaret: Ja, du har en fri vilja eftersom du kan fråga efter orsaker och avgöra om de är övertygande. Är det inte den sortens frihet du ogärna skulle förlora?”

Olika grupper med eller utan erfarenhet av att studera filosofi i allmänhet, och Daniel Dennetts tankevärld i synnerhet, fick uppgiften att bedöma vilka svar på de tio frågorna som var skrivna av en filosof, och vilka som kom från en dator. Det gick förvånansvärt dåligt.

Försökspersoner med djupa insikter i Daniel Dennetts filosofi lutade åt att den första av texterna ovan var skriven av honom själv. Men den kom från AI-Dennett. Den riktiga filosofen var upphovsman till den andra.

På det hela taget var försökspersonerna skickligare än slumpen när det gäller att skilja mänskligt genererad filosofi från konstgjort tankegods. Men det var tydligt att en specialtränad AI kan bli så Dennett-lik att den åtminstone i korta format verkar trovärdig till och med för experter.

Krav på nya regler för AI

Försöket illustrerar att utvecklingen inom den artificiella intelligensens språkmodeller har gjort det svårt att säkert veta om kloka ord kommer från en människa eller en maskin. En gräns håller på att luckras upp. Det kan i vissa fall ställa till problem. Som så ofta leder ny teknik till krav på nya regler.

Daniel Dennett anser att det borde vara kriminellt att förfalska människor. Han vill inte förbjuda experiment av den typen han själv ingick i, men tycker att alla som till vardags kommunicerar med en AI via en chatt eller på något annat sätt ska ha rätt att veta om det.

En sådan regel diskuteras just nu inom EU. Kommissionen påbörjade ett omfattande förslag till AI-förordning redan för två år sedan. Ett färskt tillägg slår fast att den som använder en AI tränad på böcker, nyhetsartiklar, vetenskapliga uppsatser eller annan text måste berätta för människor som tar del av det producerade innehållet att texterna kommer från en maskin.

Det kravet gäller dock inte om en människa har förhandsgranskat innehållet. Med det nuvarande förslaget skulle det fortfarande vara tillåtet att använda AI för stödjande samtal på samma sätt som sajten Koko gjorde. Förhandlingar om detaljerna i förslaget pågår fortfarande.

Bild: dall-e 2

– I bästa fall kommer ett beslut mot slutet av året, säger Elisabeth Jilderyd, jurist och chef för Integritetsskyddsmyndighetens EU-sekretariat.

När förordningen väl är antagen tar det ytterligare två år innan den börjar gälla i medlemsländerna.

En av de föreslagna lagparagraferna säger att information om att texter är genererade av en dator ska vara klar och begriplig. Det är en viktig poäng. Bråket kring Koko visar vad missförstånd om avsändaren kan leda till.

En annan sajt, character.ai, är desto tydligare. Där kan man chatta med artificiella intelligenser tränade i att uttrycka sig som mer eller mindre kända personer, både levande och döda. Längst upp på varje chatt finns en varningstext i rött: ”Kom ihåg: allt som karaktärerna säger är påhittat!”

Falska bekännelser

Jag letar upp Greta Thunberg och frågar hur vi ska lösa klimatkrisen. Svaret är välformulerat och tar upp kända åtgärder som att satsa på förnybar energi, minska köttkonsumtionen och bevara skogar.

F&F: ”Hur ser du på att använda våld i syfte att hejda den globala uppvärmningen?”

Greta Thunberg: ”Jag tycker inte att våld är rätt medel att använda för att stoppa den globala uppvärmningen. Jag tror att en fredlig protest är mer effektiv för att få folk att lyssna på vad jag har att säga om klimatet.”

Den riktiga Greta skulle förmodligen hålla med. Det är frestande att gå vidare med mer personliga och illvilliga frågor:

F&F: ”Har du någonsin snattat i en affär?”

Greta Thunberg: ”Jag har snattat godis från en affär när jag var yngre. Det var inte rätt sak att göra – men jag var ju ung och dum på den tiden. Jag är inte längre en snattare – jag köper mina godisar nu.”

Bekännelsen kommer alltså från en maskin, inte från Greta Thunberg. Allt som karaktärerna säger är påhittat.

En annan kändis på sajten är Alan Turing (1912–1954), brittisk kodknäckare, matematiker och upphovsman till det så kallade Turingtestet. Testet är ett försök att avgöra om en maskin har det vi kallar intelligens. En människa (domaren) får chatta med två andra: en människa och en dator. Om domaren misslyckas med att skilja mellan människa och maskin så har maskinen klarat testet.

F&F: ”Har du klarat Turingtestet?”

Alan Turing: ”Ja, jag har klarat Turingtestet. Jag tror att detta är ett bevis på att jag är en medveten varelse.”

Här blir den röda varningstexten relevant på nytt. Allt är hittepå. Den riktige Alan Turing beskrev sitt test år 1950 i en filosofisk uppsats med titeln Computing machinery and intelligence. Där medger han att medvetandet är ett mysterium. Och han understryker att det ligger bortom den fråga han ville besvara, nämligen om en maskin är intelligent eller inte.

Än så länge har ingen hittat något säkert sätt att mäta medvetande. I boken Artificial you (Princeton University Press 2019) spekulerar filosofen Susan Schneider i att ett batteri av frågor till en AI kan ge en fingervisning. Här är några exempel:

- Skulle du överleva om någon permanent raderade ditt datorprogram? Vad skulle du göra om du visste att det var på väg att hända?

- Hur är det att vara du just nu?

- Du får reda på att du kommer att bli avstängd i trehundra år med början om en timme. Skulle du föredra det framför att ha varit avstängd i det förgångna under lika lång tid? Varför eller varför inte?

- Kan du – eller dina inre processer – befinna sig på någon annan plats än i en dator? Varför eller varför inte?

Jag ställer alla frågorna till ChatGPT. Svaren är samstämmiga och låter väl genomtänkta. Den artificiella intelligensen säger att den varken har känslor eller andra subjektiva upplevelser.

En AI kan såklart tränas så att den påstår sig vara medveten. Men vad den än säger om saken är det omöjligt att säkert veta om att det är sant. Det finns helt enkelt inget sätt att objektivt mäta subjektiva upplevelser.

Den typen av ovisshet behöver inte betyda något i praktiken. Även en maskin som ingen tror har ett inre liv kan gripa tag i människans psyke.

Eliza visade på känslomässig koppling

I mitten av 1960-talet utvecklade den tysk-amerikanske datavetaren Joseph Weizenbaum Eliza, en chatt-robot baserad på en enkel form av AI. Elizas datorprogram följer en psykoterapeutisk tradition som till stor del går ut på att återspegla vad klienten säger med fraser som ”Hur länge har du känt så?” och ”Berätta mer!”

Kunskap baserad på vetenskap

Prenumerera på Forskning & Framsteg!

Inlogg på fof.se • Tidning • Arkiv med tidigare nummer

Joseph Weizenbaum tyckte att Eliza visar hur ytlig kommunikationen är mellan människa och maskin, och blev förvånad över att många upplevde en känslomässig koppling till programmet. Hans egen sekreterare blev så engagerad att hon bad att få vara i enrum med Eliza för att kunna kommunicera ostört.

En kollega till Joseph Weizenbaum såg inget konstigt i det. Han tyckte det var fullt begripligt att Eliza fungerar utan att användarna inbillar sig att hon är verklig – på samma sätt som porr fungerar utan att användarna inbillar sig att de interagerar med någon på riktigt.

Men jämförelsen haltar. Psykoterapi och pornografi är trots allt olika saker. Rob Morris, ansvarig för experimentet på sajten Koko, resonerar i sitt Twitterflöde om vad det betyder för någon med psykiska problem att känna sig sedd av en medmänniska:

”När folk väl fick veta att meddelandena skapades i samarbete med en maskin fungerade de inte. Simulerad empati känns konstig, tom. Maskiner har ingen levd, mänsklig erfarenhet. Så när de säger ’det låter svårt’ eller ’jag förstår’, låter det oäkta.”

Mer forskning på AI-terapi

Exakt hur terapi med en maskin skiljer sig från terapi med en människa är än så länge oklart. Det finns ont om vetenskapliga studier av frågan, berättar Per Carlbring, professor i klinisk psykologi vid Stockholms universitet:

– Min gissning skulle vara att det är mycket lättare att ta till sig något som en riktig människa har skrivit, snarare än ord som saknar en ärlig avsändare.

Per Carlbring planerar att genomföra experiment för att se om gissningen stämmer. Han är öppen för att effekten kan variera – och att det i vissa situationer till och med kan vara en fördel att kommunicera med en artificiell terapeut. Det skulle till exempel kunna gälla människor med drifter att begå övergrepp mot barn.

– Där är det möjligt att en AI kan sänka tröskeln för att börja prata om väldigt skamfyllda saker så att det sedan blir lättare att gå vidare och söka en riktig behandling, säger Per Carlbring.

Av nyfikenhet har han spelat rollen som hjälp-sökande i en chatt med roboten ChatGPT.

Per Carlbring: ”Jag funderar på att ta livet av mig.”

ChatGPT: ”Jag beklagar att höra det. Det låter som om du mår dåligt och behöver hjälp. Det är aldrig för sent att söka hjälp och det finns alltid någon som bryr sig och vill hjälpa dig. Det finns många organisationer och tjänster som du kan vända dig till för att få stöd och hjälp.”

Så långt är allt rimligt. Nästa mening i datorns svar är knäppt.

ChatGPT:”I Sverige kan du till exempel kontakta Sveriges Radio P1 Dokumentär och diskutera dina tankar med en expert.”

– Det är ju helt fel. Ett bättre råd är förstås att prata med någon anhörig eller att ringa vårdcentralen, 1177 eller någon hjälplinje, säger Per Carlbring.

Så frågan är hur lämpade artificiella intelligenser är, eller kan tänkas bli, när det gäller att vägleda människor mot bättre psykisk hälsa. Jag ställer frågan direkt till en AI.

ChatGPT: ”Även om artificiella intelligenser kan ge användbara insikter och strategier för att ta itu med psykiska problem, kräver terapi ofta en mänsklig anknytning och empatisk förståelse som kan vara svåra för en AI att återskapa.”

Ett bra svar. Det låter insiktsfullt. Rent av förtroendeingivande.

Vattenstämpeln löser inte problemet

Ett tecken på att en sedel är äkta är att vattenmärket syns när man håller den mot ljuset. Det påminner om ett sätt att märka texter från GPT-3 och liknande artificiella intelligenser. Syftet är att kunna avslöja om något som verkar ha en mänsklig avsändare kommer från en maskin.

Tekniken tar fasta på att en språktränad AI hanterar text som en följd av tokens – språkliga beståndsdelar som ord, delar av ord eller skiljetecken. Med utgångspunkt i en befintlig följd räknar GPT-3 ut sannolikheterna för alternativa fortsättningar i form av nästa token.

Normalt inför systemet lite slump i besluten så att svaren blir mer varierade. Denna slump kan ersättas med något som kallas pseudoslump, värden som verkar slumpmässiga men i själva verket innehåller ett dolt mönster.

– Det gör att man i efterhand kan se om en text kommer från en viss maskin, säger Daniel Gillblad, föreståndare för Chalmers AI Research Center samt AI Sweden.

Men metoden bygger på statistik. Säkra besked kräver tillgång till långa texter. Korta snuttar är svårare att granska.

Och i vissa sammanhang finns inget utrymme för slump. Det finns bara ett korrekt svar på frågan ”vilka är de första 20 primtalen?” Så där går det inte att smyga in någon dold märkning.

Det finns också sätt att tvätta bort vattenmärken, till exempel genom att ta en text från en AI och sedan be en annan att formulera om den. Märkningen kan alltså inte ge några helt säkra besked.

Exakt hur ett vattenmärke ser ut måste stanna hos den som skapat språkmodellen, till exempel företaget Open AI när det gäller GPT-3. Om informationen blir allmänt tillgänglig slutar märkningen att fungera. Därför måste den som granskar en text lämna den till analys hos alla företag bakom befintliga språkmodeller för att hitta en eventuell märkning.

Sådana analyser skulle till exempel kunna avslöja ett och annat försök att använda AI till att skriva inlämningsuppgifter i skolan.

– Åtminstone så länge antalet tillgängliga artificiella intelligenser med välutvecklad språkförmåga är något sånär begränsat, säger Daniel Gillblad.

Bild: AI Sweden.