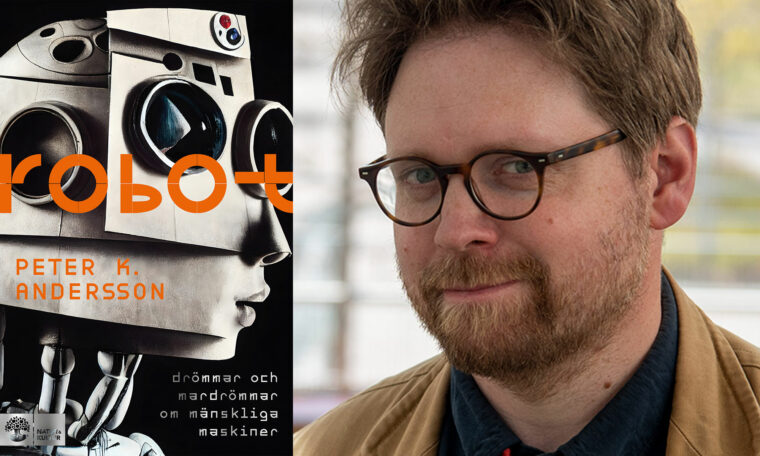

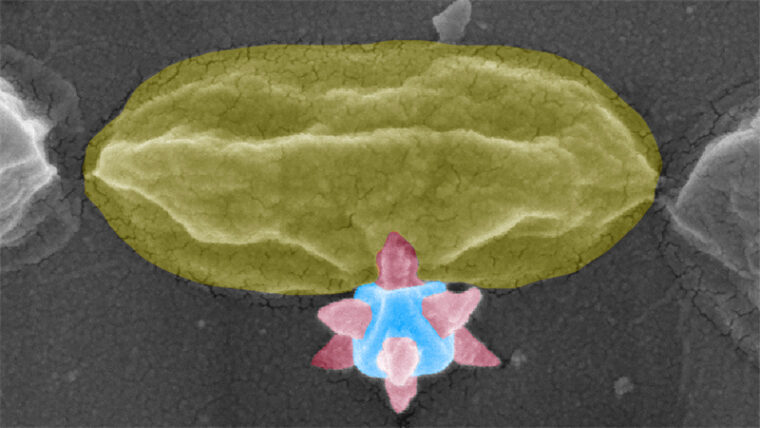

Den sydkoreanska roboten SGR-1 övervakar gränsen mellan Syd och Nordkorea. Om den upptäcker människor som inte kan ropa rätt lösenord larmar den, eller öppnar eld.

Bild: Kim Dong-Joo / Scanpix

Licens att döda

När militära robotar byggs för att döda människor måste de utrustas med etiska principer. Men vem är ansvarig om de inte följer dem?

Det här är en artikel från 2012.

De flesta fjärrstyrda robotar är obeväpnade och utför oförargliga uppgifter som att övervaka landområden eller desarmera sprängladdningar. Men en hel del av de tiotusentals militära robotar som på senare tid har börjat användas runt om i världen ställer oss inför dilemman med robotetik.

Mest kontroversiella är de obemannade flygplanen, de så kallade drönarna. I snart tio år har de använts av amerikanska militärer i Irak och Afghanistan och fjärrstyrs ofta från kontrollrum långt bort i Nevadaöknen i västra USA. Besluten att avfyra missiler görs då av soldater som själva sitter i säkerhet långt bort från krigsområdet.

Ett vanligt argument mot drönare är att operatörerna lätt blir avtrubbade. De inser kanske inte att det som liknar ett tv-spel faktiskt handlar om liv och död, eftersom de aldrig själva behöver riskera sina egna liv.

De som, å andra sidan, förespråkar användningen av drönare för fram exakt samma argument, men deras slutsatser är precis motsatta. De menar att människor som inte själva är hotade till livet är mindre lätta på hanen än stridspiloter i bemannade flygplan, som på bråkdelar av en sekund måste fatta beslut om beskjutning av de mål de ser på marken. Därför, menar de, att obemannade flygplan ur moralisk synvinkel är att föredra, eftersom besluten om eldgivning tas av personer som inte känner behovet av att skjuta först och fråga sen för att rädda sig själva.

Redan i Gamla testamentet betonas vikten av att minimera skador på civilbefolkningen när en stad belägras. Men åsikterna om vad som är moraliskt acceptabelt i krig har varierat. År 1139 förbjöd till exempel påven användningen av armborst. Skälet var att dessa gjorde det möjligt att döda på långa avstånd.

Människorättsorganisationen Human rights watch förespråkar att flygbombning i befolkade områden ska ske med så kallade smarta bomber, som själva styr mot ett förutbestämt mål. Organisationen gör förstås inte detta för att den gillar flygbombning med smarta bomber, utan för att smarta bomber anses orsaka färre oavsiktliga civila skador. I övrigt finns det för närvarande väldigt få riktlinjer för användning av robotar i krig, men det är högst troligt att sådana kommer att finnas med i framtida internationella konventioner. Att reglera det helvete som krig är, handlar om att välja mellan pest och kolera.

De internationella överenskommelser om krigföring som gäller i dag formulerades redan under 1900-talets första hälft, framför allt i Genèvekonventionerna och i Haagkonventionerna. Nya etiska problem uppstår i takt med att tekniken blir alltmer avancerad. Robotarna blir till exempel alltmer autonoma, självstyrande, och det finns militära robotar som själva får besluta när och hur vapen ska användas.

En av dem är SGR-1, tillverkad av företaget Samsung. Den används för att övervaka gränsen mellan Syd- och Nordkorea, och kan automatiskt detektera och skjuta människor som rör sig i de otillåtna gränsområdena.

Ska sådana robotar över huvud taget tillåtas? Och ska de i så fall utrustas med moraliska principer som styr deras handlande? Och hur ska dessa principer utformas?

För att svara på den sista frågan kan vi gå till de centrala riktlinjer för soldaters beteende i krig som beskrivs i Genèvekonventionerna. Diskrimineringsprincipen innebär att man bara får sikta på stridande och inte på civila. Proportionalitetsprincipen innebär att de förväntade civila skadorna måste stå i rimlig proportion till de förväntade militära vinsterna med en militär operation.

En mänsklig soldat som följer denna typ av principer kan anses handla etiskt korrekt. Samma principer skulle även kunna användas för att konstruera etiska robotar. En militärrobot som beter sig som en korrekt mänsklig soldat skulle alltså betraktas som etiskt klanderfri.

Även om detta fungerar som en god första ansats leder det inte hela vägen – vi kräver sannolikt mer av en robotsoldat än av en mänsklig soldat. En mänsklig soldat kan ibland ursäktas för att ha skjutit först och frågat sen. Men av en robotsoldat är det naturligtvis rimligt att kräva att den riskerar sitt liv i större utsträckning än sina mänskliga kolleger.

Nu är dagens robotar mycket långt ifrån den typ av artificiell intelligens som vi ser i tv-serier som Äkta människor, eller de mer krigiska robotarna i filmerna Terminator och Star wars. Det krävs tekniska och vetenskapliga genombrott inom en rad områden innan en robot kan analysera och förstå vad som sker i omgivningen, och därefter agera för att uppnå sina egenformulerade mål.

En stor teknisk utmaning för robotar som SGR-1 är att kunna skilja mellan civila och stridande. Att avgöra om en beväpnad, civilklädd pojke bör betraktas som stridande eller inte är ett dilemma redan för en människa, och det blir inte lättare för en robot. Vissa forskare menar att problemen är så stora och principiellt svåra att de aldrig kan lösas på ett tillfredsställande sätt, och att vi därför bör stoppa utvecklingen av alla militära robotar.

I dag tillämpas i stället principen begränsad moralitet, vilket innebär att robotarna enbart används i situationer där de moraliska övervägandena är starkt förenklade. SGR-1 används till exempel i inhägnade gränsområden där inga människor, vare sig civila eller militärer, får vistas. Då blir diskrimineringsprincipen betydligt lättare att efterleva.

Framtidens robotar kommer dock att ställas inför svårare val. Kan då en robot betraktas som moraliskt ansvarig för sina handlingar?

När det gäller människor kan moraliskt ansvar ses som en mekanism för att kontrollera beteenden och upprätthålla samhällsnormer. Detta främjar handlingar vi ser som goda och undertrycker handlingar vi ser som onda.

Kommer framtidens intelligenta och autonoma robotar att bedömas som människor? Det spontana svaret på den frågan brukar vara ”nej”. Motiveringen är att robotar bara gör det som de programmerats att göra. Det moraliska ansvaret ligger då helt på dem som utvecklar, tillverkar och använder robotarna.

Även om det är en rimlig slutsats för de robotar som existerar i dag, så finns det anledning att gardera sig. Redan i dag betraktas människor som moraliskt ansvariga i varierande grad. Små barn anses inte vara moraliskt ansvariga för sina handlingar, och ansvaret växer gradvis med stigande ålder. En anställd kan, till viss grad, skylla på chefen och därigenom avsäga sig ansvar för sina handlingar på jobbet. Vi tillskriver dessutom redan nu döda ting moraliskt ansvar. Företag, alltså juridiska personer, kan inneha egendom och teckna avtal, och de kan både åtalas och straffas och dessutom ibland anklagas för det vi kallar omoraliskt beteende.

Det finns redan exempel på människor som anklagar industrirobotar för de fel som uppstår under arbetet. Man tilldelar då robotarna ett ansvar som beror på deras autonomitet, det vill säga deras grad av självstyrande, eller om man så vill, intelligens. Framtidens robotar, såväl militära som civila, kommer definitivt att bli mer autonoma, och de kommer också att kunna lära sig av sina erfarenheter, på samma sätt som människor gör. Deras beteende kommer därför inte bara att bero på det som programmerarna har stoppat in i robotens dator vid tillverkningstillfället, utan i stor grad även på det som roboten har upplevt efter att den lämnat fabriken. Det är inte alls otroligt att en sådan robot kommer att betraktas som moraliskt ansvarig för sina handlingar.

Om vi kan utdöma straff för robotar som misskött sig uppstår ännu ett etiskt problem: Hur ska vi behandla dem?

Föreställ dig en militärrobot som löpt amok och begått ett krigsbrott. Vid närmare analys av robotens minne framkommer att anledningen till dess brott står att finna i robotens tidigare upplevelser: den har vid upprepade tillfällen tvingats bevittna massakrer på människor och robotar som den haft i uppdrag att försvara. Detta betraktas som förmildrande av rätten. Roboten undgår därigenom lagens hårdaste straff, permanent avstängning, och får i stället tillbringa resten av sitt liv som robotsopare i stadsbibliotekets källare.

Om den behandlingen kan anses som etiskt korrekt, och meningsfull, får framtiden utvisa.

Kunskap baserad på vetenskap

Prenumerera på Forskning & Framsteg!

Inlogg på fof.se • Tidning • Arkiv med tidigare nummer