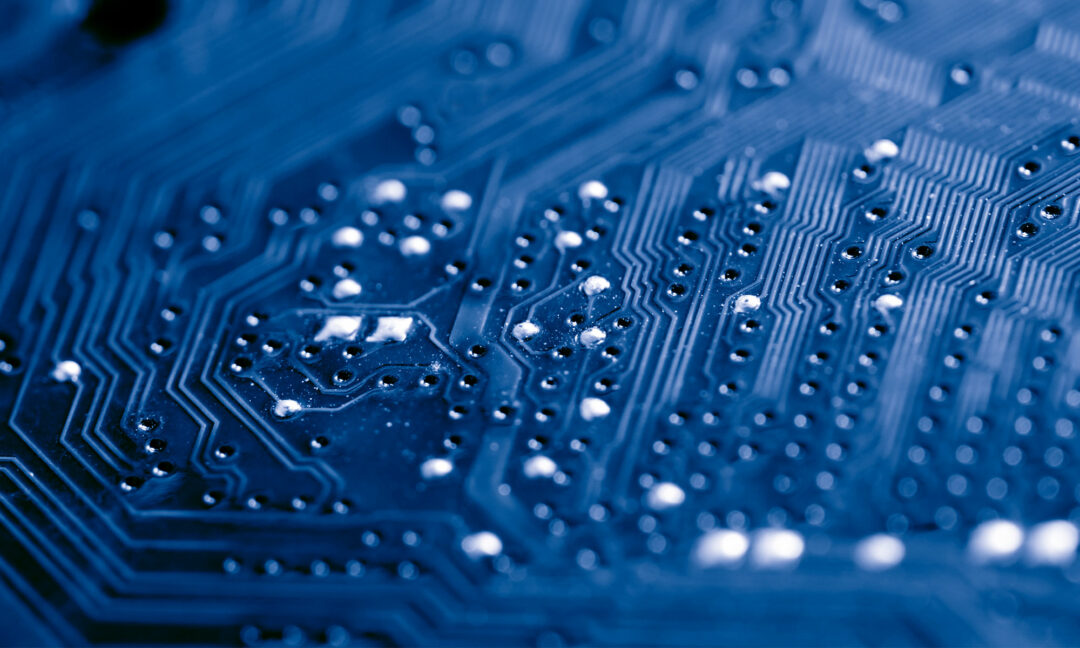

Bild: Getty images

Under huven på artificiell intelligens

Så funkar maskinerna som kan ge en illusion av att tänka själva.

Smarta maskiner imponerar

Plötsligt verkar maskiner kunna måla och skriva och till och med programmera i stort sett lika bra som människor. Den tidigare esoteriska frågan om hur artificiell intelligens kan utgöra ett hot mot mänskligheten har bollats upp till att diskuteras på tv och kultursidor. Artificiell intelligens – AI – finns numera överallt. Om du använder ett bildfilter för att sätta hundöron på dig själv eller byta plats på din och din kompis ansikte, då är det en sorts AI som känner igen vilka delar som är vilka i bilden. Om du använder Googles översättningsverktyg är det AI som analyserar meningar och hittar motsvarande på det språk du önskar. Har du en bil som hjälper dig att backa eller som själv håller sig i rätt fil på vägen – då är det också en sorts AI.

AI kan betyda en rad olika saker. I dag handlar utvecklingen till stor del om system som lär sig själva. Maskininlärning kallas det, och grunderna för det har funnits länge. Tekniken bygger på en idé som utvecklades i mitten av 1900-talet: artificiella neuronnät. De är datorprogram som från början var tänkta att simulera hur neuroner i hjärnan behandlar information. I praktiken fungerar de inte på samma sätt som biologiska neuronnät, men grundprincipen har visat sig vara kraftfull.

Bild: Henrik Östlund

– Det som har hänt på senare år är att man har fått så mycket mer datorkraft så man kan träna de här neuronnäten på ett effektivt sätt, säger Moa Johansson, som är forskare i datavetenskap vid Chalmers tekniska högskola.

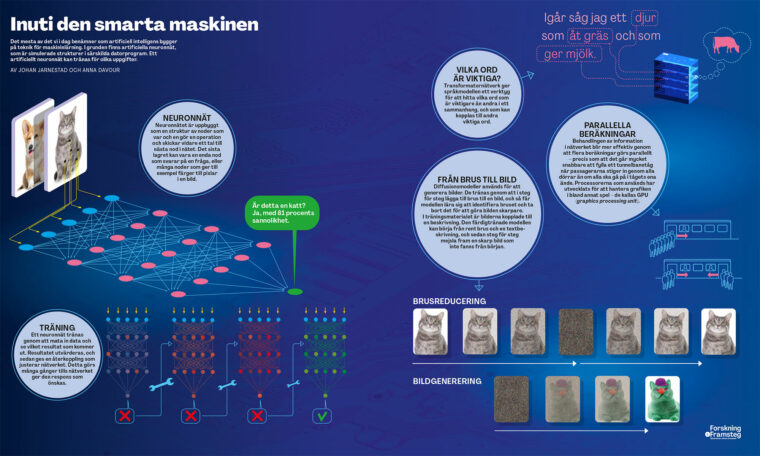

I de artificiella neutronnäten matas information genom olika lager av bearbetning. När neuronnätet består av flera lager talar man om djupinlärning. Varje skikt består av noder som tar emot information, som justeras och skickas vidare till flera noder i nästa skikt, som tar vid och fortsätter behandlingen. I slutet presenteras ett resultat. I dag kan nodernas beräkningar göras parallellt med hjälp av samma sorts processor som har utvecklats för verklighetstrogen grafik i datorspel, GPU (graphics processing unit).

Träningen av ett neuronnät kan bestå i att det testas på olika mönster och uppdateras genom en automatisk algoritm, ända tills resultaten som kommer ut stämmer med det programmeraren eller forskaren vill att nätet ska åstadkomma.

De senaste åren har vi sett ett genombrott för AI-system som kan konstruera helt nya texter och bilder – generativ AI. Till skillnad från tidigare system kan de prestera resultat som ofta uppfattas som likvärdiga med vad en människa kan göra.

Dagens generativa AI har blivit möjlig framför allt genom ren datorkraft. Den första versionen av företaget Open AI:s språkmodell, GPT-1, kom 2018 och hade 117 miljoner parametrar. GPT-4 från 2023 sägs ha över tusen miljarder parametrar. Det är alltså tiotusen gånger fler än GPT-1. Att träna dessa gigantiska neuronnät och uppdatera parametrarna kräver enorma datorresurser som bara några få stora företag besitter. Andra använder mycket mer begränsade system.

Bild: Chalmers tekniska högskola

Forskare kan antingen bygga neuronnät själva, och träna dem från grunden, eller också utnyttjar de sådana som redan finns.

– Det kan spara en väldigt mycket tid att du inte behöver träna om det från noll. Det man kan göra är att finjustera det lite grann själv, säger Moa Johansson.

Nätverken tränas för den särskilda uppgift de ska användas för. Det kan handla om att analysera texter och kategorisera dem. Moa Johansson använder till exempel språkmodeller för att forska om texter i politiken, och hennes kollega Fredrik Johansson arbetar bland annat med hur AI-system kan användas som beslutsstöd i vården.

– Nu är det rimligt för oss att säga till datorn: ”Bygg en modell som löser det här problemet.” Det var helt otänkbart när jag började forska, säger Fredrik Johansson.

Så skapar Chat GPT text

När företaget Open AI släppte tjänsten Chat GPT hösten 2022 fick många för första gången upp ögonen för AI som kan generera text. Andra system som skriver texter har använts i åratal för att författa enkla texter utifrån information som kan presenteras i ett tydligt strukturerat format. Det finns till exempel många automatiskt genererade artiklar på Wikipedia som beskriver olika insektsarter. Det är något annat än den maskin som i dag kan svara på frågor om nästan vad som helst och formulera sig i olika stilar – Chat GPT skriver låttexter, dikter, torr skolboksprosa eller till och med ansatser till humor. Ibland lyckas den bra, ibland sämre.

Chat GPT bygger på en stor språkmodell. En sådan modell byggs upp med hjälp av ett artificiellt neuronnät som hittar samband mellan olika ord och relaterar dem till varandra. Resultatet blir en mångdimensionell karta över språket, där vissa ord är nära knutna till varandra, och andra har större avstånd. Språkmodellen kan bygga texter ord för ord genom att hela tiden förutsäga vilket ord som ska komma därnäst.

Språkmodellen utnyttjar en speciell sorts neuronnät som kallas för transformatornätverk, som uppfanns 2017. Ett sådant nätverk tittar på sammanhanget och lär sig var den ska lägga uppmärksamheten i en text. På det viset kan modellen få innehållet i en text att hänga ihop och bilda en begriplig helhet.

De stora språkmodellerna som GPT tränas på enorma mängder text från internet.

När systemet tränas går det igenom tester där utfallet kan fungera bra eller dåligt. Resultatet kopplas tillbaka med en så kallad belöningsfunktion, som systemet använder för att modifiera sig självt. Utöver de automatiska funktionerna tränas systemet manuellt av människor som utvärderar vad det gör. Det behövs för att få modellen att uppföra sig på ett önskat sätt och till exempel inte uttrycka sig rasistiskt.

Språkmodellerna matas med alla möjliga typer av texter, från skönlitteratur till manualer och datorkod. Efter träningen kan de generera text som imiterar grundläggande egenskaper hos övningstexterna, men oftast utan att upprepa dem ordagrant. Författaren och datavetaren Ted Chiang har beskrivit en sådan modell som en suddig och komprimerad avbildning av internet. En grupp forskare med bakgrund bland annat vid Googles forskningsavdelning har kallat språkmodellerna för ”stokastiska papegojor”, alltså papegojor med inslag av slump.

– I Chat GPT och liknande system har man en parameter som avgör när den ska välja vad som är nästa ord. Ska den ta det mest sannolika eller något som är lite mindre sannolikt? Ibland kan det vara bättre att ta något lite mindre sannolikt för att du kanske får mer varierad text och det låter lite bättre, säger Moa Johansson.

De allmänna principerna för hur Chat GPT fungerar är alltså kända, men detaljerna är affärshemligheter. Helt klart är att det fungerar väldigt bra, och ibland blir till och med de som jobbar med modellerna förvånade över resultatet. Forskning pågår för att förstå hur modellen bakom Chat GPT fungerar.

– Ibland tycker man att det verkar som att den resonerar lite grann. Men sen finns det alltid ett motexempel där det bara är som goddag yxskaft. Det är väldigt intressant för forskare att undersöka och försöka förstå exakt vad de här jättestora neuronnäten har för kapaciteter och inte, säger Moa Johansson.

Inuti den smarta maskinen

Så kan AI analysera och skapa bilder

Artificiella neuronnät kan också tränas för att identifiera olika föremål i bilder. De används till exempel inom astronomin för att upptäcka intressanta företeelser i bilder från stora genommönstringar av stjärnhimlen, eller inom medicinen för att hjälpa till med att bedöma röntgenbilder. De kan tränas till att känna igen olika sorters djur, eller fordon, eller till och med skilja mellan olika ansikten.

För några år sedan berättade F&F (4/2019) om AI som skapar fotorealistiska porträtt med hjälp av två nätverk som tävlar mot varandra – det ena genererar bilder och det andra försöker avgöra om bilden är ett äkta foto eller fejk. De tränar varandra till att bli bättre och bättre. Till slut kan det genererande nätverket åstadkomma bilder som är bra nog för att vi människor ska tycka att de ser riktiga ut. Tekniken kallas GAN, generative adversarial network.

Denna teknik var mycket imponerande, men kunde bara klara av en typ av material åt gången. Ett nätverk kunde göra ansikten, ett annat tulpaner, men det gick inte att göra båda samtidigt. Många av de AI-genererade bilder vi ser nu har i stället producerats genom något som kallas diffusionsmodell.

Diffusion är i fysiken och kemin en process där till exempel små partiklar sprids genom luften genom att slumpmässigt vandra fram mellan luftpartiklarna. Det är så olika vätskor eller gaser blandas med varandra. I det här fallet handlar det i stället om att steg för steg lägga till eller dra bort slumpmässigt brus från en bild.

Det färdigtränade nätverket kan utgå från rent brus och sätta ihop en helt ny bild.

Bild: Privat

När den här metoden används tillsammans med ett tillräckligt stort träningsmaterial och en tillräckligt stor beräkningskapacitet går det att träna en modell som kan känna igen olika typer av bildinnehåll, och ofta också göra en igenkännbar imitation av givna konststilar. Ibland blir resultatet slående och effektfullt, men ofta innehåller bilderna fortfarande märkligheter som ger ett surrealistiskt intryck.

Zenodia Charpy är forskare på företaget Nvidia, som tillverkar de särskilda processorer som används i många AI-tillämpningar. Hon är intresserad av nästan allt inom AI. Hon berättar om en av de senaste stora nyheterna, en visuell språkmodell från Googles AI-labb som kallas för Flamingo.

– Du har en förtränad språkmodell som arbetar med språk. Sedan har du en annan modell som förstår bilder. Och så förenar du dem med varandra, säger Zenodia Charpy.

Den här metoden används till exempel för att göra automatiska beskrivningar av videomaterial.

När AI gör fel eller orsakar problem

Varför är AI så dåligt på att rita händer, och varför kan den ge källhänvisningar till böcker som inte finns? Det här är ett par av de problem som tekniken har haft, men som kanske är mer irriterande än farliga. Värre är till exempel när systemen läcker ut hemlig information, eller blir paralyserade av information som de inte kan hantera.

Det är viktigt att förstå AI-systemens begränsningar. För några år sedan ville till exempel en grupp forskare använda AI för att identifiera hudcancer i bilder av hudfläckar. De upptäckte ganska snart att deras system först lärde sig att klassificera bilder som cancer om de innehöll linjaler, eftersom riktiga tumörer ofta hade fotograferats ihop med storleksmarkeringar. I det här fallet upptäckte forskarna själva problemet och kompenserade för det, men det illustrerar vilken typ av genvägar AI kan ta. Maskinen vet ju inte vad hudcancer är, eller ens vad det är forskarna vill att den ska titta efter. Den justerar bara sitt system så att den lyckas klassificera träningsbilderna enligt de kategorier som forskarna har placerat dem i.

Samtidigt är det just förmågan att ibland hitta helt oväntade lösningar som kan vara AI-systemens största styrka. Det gäller bara att använda dem klokt och dubbelkolla vad de faktiskt gör.

Fredrik Johansson på Chalmers tekniska högskola arbetar bland annat med AI i vården, men snarare med text än med bild. Han försöker bland annat förutsäga vilka patienter som inte kommer att bli bra, utan som kommer att komma tillbaka till läkaren igen.

– Resultatet blir inte bättre än de data vi samlar in. Så om vi inte har mätt någonting som är väldigt viktigt för att förutspå någonting, ja då kommer inte modellen heller hitta det, säger Fredrik Johansson.

Ibland kan AI-system som Chat GPT åstadkomma märkliga resultat som kallas för hallucinationer, med till synes helt rimliga formuleringar men som beskriver något som inte finns eller inte har hänt.

Bild: Jon Hollström.

– Den pratar som en människa, men det är inte en människa du pratar med. Vad den än säger så dubbelkolla, det är ditt ansvar som användare, säger Johanna Björklund som är universitetslektor i datavetenskap vid Umeå universitet.

Under en period kunde den som bad Chat GPT om referenser till någon typ av information få en lista på helt påhittade och icke-existerande artiklar eller böcker. Det tycks fungera mycket bättre nu, om än inte perfekt. Chat GPT kan till exempel ge en lista på artiklar som visar motsatsen till vad frågan handlar om, även om det gäller samma ämnesområde.

Att bildgenererande AI-system har svårt att avbilda händer kan ge en riktig obehaglig effekt eftersom händer är väldigt viktiga för oss människor. Vi reagerar instinktivt på att något ser fel ut, och händer är ökänt svåra att avbilda även för duktiga konstnärer som vet precis hur händer fungerar. Datorsystem som tränats på platta bilder har däremot ingen förståelse av att en hand har en tredimensionell struktur som måste hänga ihop på ett visst sätt inuti. De lär sig mycket lättare att få huden och detaljer på fingrarna att se riktiga ut, vilket får extra tummar eller osammanhängande handflator att se ännu mer monstruösa ut.

– Om systemet blir tillräckligt komplext så kommer det att kunna upptäcka konceptet ben och ha en intern representation som motsvarar skelettstrukturen. Det kan vara så att det inte finns tillräckligt med träningsdata, eller att händer är för komplicerade för att kunna lära sig med de energimängder vi vill investera, säger Johanna Björklund.

Det som gör de nya AI-systemen överraskande men också svåra att förstå och arbeta med är att det är omöjligt att veta exakt hur de fungerar. Det är som en svart låda där data stoppas in i ena änden och ett okänt maskineri på insidan spottar ut ett resultat på andra sidan.

– Det gör det ju jättesvårt att garantera beteendet hos datorsystem som har sådana här tränade modeller inbäddade, säger Johanna Björklund.

Ska den typen av modeller användas för att styra maskiner eller göra kritiska uppgifter är det viktigt att kunna lita på att de beter sig som förväntat. Många forskare ägnar sig åt att försöka göra en formell och matematisk beskrivning av vad AI:n gör. Finns det till exempel två olika uppsättningar indata som ger samma utdata? Eller finns det några särskilda indata som vi kan vara säkra på ger utdata med just en viss egenskap?

System som Chat GPT ges en särskild ”uppfostran” innan de presenteras för allmänheten, för att de inte ska bete sig illa eller göra olämpliga saker. De får inte beskriva metoder för att begå brott, eller uppmana till självmord, eller säga rasistiska saker. Sedan lång tid tillbaka är det känt att AI-system har väldigt lätt att plocka upp fördomar och systematiska orättvisor och befästa dem. Till exempel har det hänt att kvinnor rankas lägre än män när ett automatiskt system ska sortera ansökningar till prestigefyllda tjänster. Att motverka sådana oönskade beteenden är ett stort arbete, och hur det görs är också till stor del affärshemligheter.

Ytterligare ett problem är att känsliga uppgifter, till exempel kreditkortsnummer, som delas med en chattbot kan bli en del av dess kunskap som går att plocka fram i efterhand. De som bygger sådana system behöver vara pålitliga och medvetna om sådana risker så att de kan hindra att de uppkommer.

Det finns alltså många svårigheter och potentiella problem med AI-tekniken redan utan de risker som diskuterats mycket – om att AI eventuellt utvecklar egna mål eller används av människor med ont uppsåt.

Tänker datorn som en människa?

När artificiella neuronnät uppfanns var de bland annat tänkta att testa hypoteser om hur hjärnan fungerar. Det betyder inte att dagens artificiella neuronnät är uppbyggda på samma sätt som en hjärna.

På 1950-talet ställde datorpionjären Alan Turing upp kriterierna för ett test av om en maskin har intelligens jämförbar med en människa. Hans test går ut på att gränsen går när en människa kan prata med maskinen utan att kunna avgöra om det är en människa eller inte. Somliga talar om 2023 som året då AI på stor skala klarade Turingtestet – inte minst genom GPT 4 som ligger till grund för den senaste versionen av Chat GPT. 2022 skapade ingenjören Blake Lemoine rubriker när han gick ut med sin uppfattning om att Googles AI, som han jobbade med, hade utvecklat ett medvetande och hade känslor. Han var övertygad av den respons han fick från sitt AI-system. Andra var inte lika övertygade.

Vissa forskare pratar om artificiell generell intelligens, som kan hantera olika typer av problem. Sådan artificiell intelligens ser vi fortfarande inte. Däremot har vi människor väldigt lätt att tolka in intelligens i den respons vi får från maskinerna.

– När systemen ger flytande svar är det är väldigt lätt hänt att man omedvetet antropomorfiserar, att man tolkar systemet som människoliknande. Men bara för att maskinen kan svara väldigt bra på text så betyder inte det att den har någon egen vilja eller avsikt, säger Moa Johansson, forskare i datavetenskap vid Chalmers tekniska högskola.

Turingtestet visar alltså inte vilken maskin som uppnått mänsklig intelligens, visar det sig, utan snarare bara vilken maskin som lärt sig att imitera mänskligt språk. Men det är ett stort framsteg i sig.

Prenumerera på Forskning & Framsteg!

10 tidningsnummer om året och dagliga nyheter på fof.se med kunskap baserad på vetenskap.