Så går det att ”lura” militära AI-system

Försvarsmakter världen över satsar på AI. Men det finns risker med tekniken. Motståndare kan till exempel manipulera systemen så att en bild på en bil tolkas som en stridsvagn visar en rapport från Totalförsvarets forskningsinstitut, FOI.

Det finns ett stort intresse för att använda AI i militära sammanhang men tekniken har risker.

Bild: Getty Images

Den snabba utvecklingen av Artificiell intelligens påverkar de flesta sektorer. Det gäller även försvarsmakter världen över som satsar på tekniken. Det amerikanska försvarsdepartementet inrättade till exempel nyligen en speciell enhet för generativ AI, det vill säga AI-systemet som likt Chat GPT kan skapa texter eller annan media efter att ha tränats på stora mängder data.

Men det finns risker med att använda den här typen av AI i militära sammanhang. Motståndare kan på olika sätt utnyttja sårbarheter i systemet. Det är till exempel möjligt att ”förgifta” data som AI-modellen tränas med. Resultatet kan bli att en bild av en bil tolkas som en stridsvagn. Det visar rapporten ”Angrepp och vilseledning av militära AI-system” som forskare vid FOI gjort på uppdrag av Försvarsmakten.

– Många tror att AI kan lösa allt men man måste vara medveten om att det finns svagheter. AI-system fungerar inte som människor och kan förvirras, ibland på oväntade sätt, säger Björn Pelzer, forskare på FOI:s avdelning Cyberförsvar och ledningsteknik och en av författarna till rapporten.

Osynligt för mänskliga ögat

I rapporten undersöker forskarna tre olika sätt att manipulera AI-system. I det första fallet handlar det om att lura bildigenkänningssystem. För att lära sig känna igen olika föremål tränas AI-systemet först på stora mängder bilder.

Genom små förändringar av träningsbilderna går det att få modellen att lära sig fel. I vissa fall är förändringarna osynliga för det mänskliga ögat men gör att AI-modellen tolkar bilden fel och tror att en bil är en stridsvagn.

I praktiken är det svårt att smyga in de manipulerade bilderna i träningsdata, men det är viktigt att veta att risken finns.

– Det gäller både för den som vill vilseleda en motståndare eller den som använder ett AI-system, säger Björn Pelzer.

Risk att hemliga dokument läcker ut

I det andra fallet testade forskarna om det gick att få fram hemlig information ur stora generativa språkmodeller. För att lära en modell att utföra en viss uppgift måste den först tränas med stora mängder träningstexter. Själva träningstexterna sparas inte i modellen men de lämnar spår så att det i efterhand går att återställa delar av träningsdata.

– Vi tränade en modell maximalt och då kunde vi återställa ungefär 20 procent. I praktiken går det kanske att få ut 5 procent, säger Björn Pelzer.

I många sammanhang kanske det inte spelar någon roll, men om modellen tränats på hemliga militära dokument finns en risk att uppgifterna läcker ut på det här sättet.

– Det är en risk som är viktig att vara medveten om inte bara i militära sammanhang, utan kan också gälla till exempel polisen.

Oväntat beteende förvirrar robot

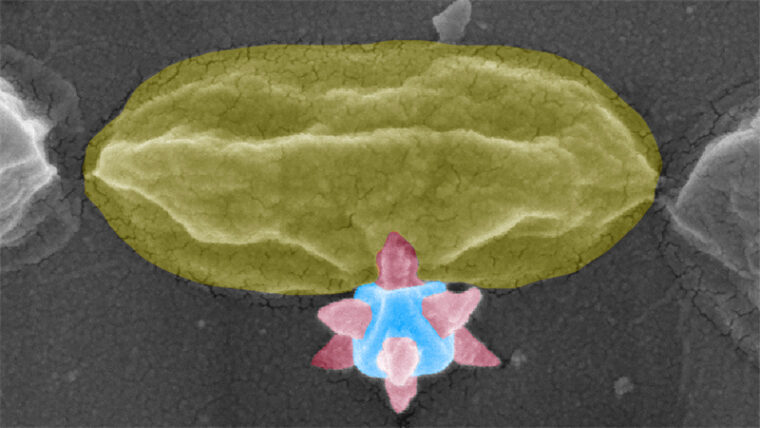

I det sista fallet visade forskarna att det är möjligt att förvirra en autonom robot genom att motståndaren beter sig på ett oväntat sätt. Försöket gick ut på att låta två virtuella robotar kämpa mot varandra. Den attackerande roboten hade lärt sig att ta sig förbi en motståndare genom att träna attacker. Varje gång den lyckades fick den en belöning.

– I det här fallet hade motståndaren optimerats för att förvirra den attackerande roboten och slängde sig ner och viftade med armar och ben på konstiga sätt. Då fattar inte roboten som ska ta sig förbi vad som händer och även den trillar omkull.

Än så länge finns få tecken på att den här typen av attacker används i praktiken men tekniken är under snabb utveckling. Det kommer ständigt nya uppdaterade AI-modeller och även nya sätt för att manipulera dem.

I en uppföljande rapport kommer FOI-forskarna att fokusera på hur stora språkmodeller, som den som används i Chat GPT, kan försvaras mot manipulation.

– En annan viktig fråga är hur mycket man kan lita på vad modellerna säger. Om de till exempel används för att sammanfatta stora textmängder gäller det att kunna mäta och bedöma att det som kommer ut är korrekt och inte något som den hittat på, säger Björn Pelzer.

Kunskap baserad på vetenskap

Prenumerera på Forskning & Framsteg!

Inlogg på fof.se • Tidning • Arkiv med tidigare nummer