På väg mot sinnenas fulla bruk

Konstgjorda sinnen kommer aldrig att bli som människans. Men målet för dem som utvecklar sensorer och analysprogram är inte heller att efterlikna oss. Målet är att ge robotarna en bild av världen, så att de kan fungera i den.

Elvis faller. Han försöker igen, stapplar rakt fram, klarar fyra meter. Om ett halvår hoppas forskarna att Elvis kan både svänga och gå till bestämda platser. Exakt när är svårt att säga – Elvis är en robot som lär sig själv. Allt han har att gå efter är data från fyra olika typer av sensorer – motsvarande människans syn, hörsel, känsel och balanssinne. Och så håller Elvis reda på robotkroppens och motorernas läge. Hans styrprogram är skrivna med så litet förutfattade meningar om omvärlden som möjligt. Resten ska han ta reda på själv.

Elvis är byggd på Chalmers tekniska högskola i Göteborg. En annan svensk robot är Warp – ett fyrbent insektsliknande metallskelett – utvecklad på Kungl Tekniska Högskolan i Stockholm. Warp stapplar också rätt så illa. Planen är att den ska kunna gå ordentligt i mars i år. Men den lär sig inte på samma hårda sätt som Elvis. Här är det programmerarna som försöker fundera ut hur gången ska gå till och sedan knacka in detta i Warps styrprogram.

Från början var Warp ett examensarbete för några civilingenjörer. Nu är den en testrobot för de forskare som studerar gång. Utmaningen för Warp är att gå som riktiga fyrbenta djur. Det betyder att roboten måste kunna tappa balansen, precis som en människa omedvetet gör i varje steg. För att ändå behålla kontrollen krävs ett fungerande balanssinne, några tryckkänsliga sensorer och full kontroll över benens läge.

Människans tio sinnen

Både Elvis och Warp är självgående: autonoma. Till skillnad från sina förfäder industrirobotarna måste de klara sig i en okänd, allmän miljö. I båda robotarna spelar sensorer och omedelbar behandling av indata en central roll – en behandling som till stor del går ut på att under tidspress hitta den viktiga informationen i ett enormt flöde av indata.

Den behandlingen och problematiken liknar på sätt och vis människans. Hon har egentligen betydligt fler sinnen än de vanliga fem: syn, hörsel, lukt, smak och känsel. Känselsinnet omfattar sålunda minst fem olika delsinnen. Och smärta kan antagligen räknas som ytterligare ett sinne. Balanssinnet är ett eget sinne, liksom det sinne som håller reda på musklernas spänning och kroppens läge. Ytterligare inre sinnen finns för att känna av blodtryck, gasnivåer osv. Men även om man med ”sinne” bara menar de sinnen som registrerar vad som händer runt omkring kroppen blir de betydligt fler än fem.

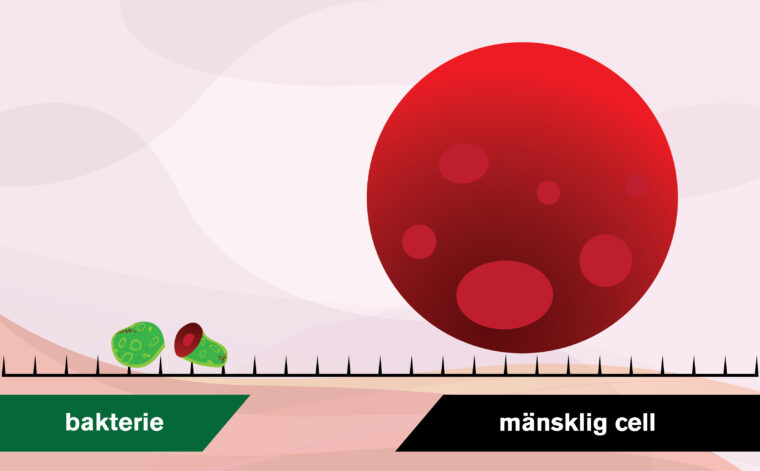

Genom att räkna antalet mottagarceller går det att uppskatta hur mycket information som människans sinnen levererar till hjärnan. Några celler är känsliga för ljus, andra för tryck, temperaturförändringar eller vibrationer. De mest komplicerade är kanske de som känner av kemiska signaler och som används för lukt och smak. Mängden information är inte jämnt fördelad mellan de olika sinnena. De som levererar mest information är syn, hörsel och känsel, minst kommer från lukt och smak. Totalt handlar det om mer än 11 miljoner bitar per sekund, för att tala datorspråk.

100 000 bitar ska bli 30

Det är inte många av dessa miljontals bitar som når ända fram till vårt medvetande. Exakt hur mycket är svårt att uppskatta. De försök som har gjorts pekar på några tiotal bitar per sekund. Det betyder att bara en bit på miljonen överlever hjärnans filter – åtminstone när det gäller vår omedelbara bild av omvärlden.

En maskin som försöker analysera mänskligt tal och göra om det till skrivna ord behöver sålla lika kraftigt: 100 000 bitar per sekund registreras av en mikrofon, och av det ska det bli 30 bitar effektiv information: två ord.

Tack vare snabb datorteknik och förfinade sensorer kan de raskt och exakt registrera och analysera information. Det finns sensorer som kan registrera samma saker som människans sinnen kan registrera: bilder, ljud, tryck, temperatur, vibrationer, doft- och smakämnen. Robotar kan se så pass bra att de kan styra en bil längs en väg. Elektroniska sensorer kan känna igen de ämnen som människor tycker luktar som muffins eller ruttet kött.

Så långt går det bra att låta maskinerna efterlikna de mänskliga sinnena – även om det mänskliga ögats dynamik, eller hudens miljontals känselceller, är svåra att återskapa.

Men bara för att man har lyckats omvandla en mikrofoninspelning till korrekta ord, eller tolka fram en rörelse ur en videosekvens, så betyder inte det att en robot kan höra eller se. Maskinerna saknar medvetande. De upplever inte något med sina sinnen. Det är fortfarande vi människor som i slutändan får tolka de data roboten samlar på sig och känna efter vad de innebär. Till skillnad från den mänskliga hjärnan är en robots huvud hierarkiskt uppbyggt. I toppen finns ett styrprogram – inte något medvetande – som hanterar och registrerar det som roboten ser och hör.

Det riktigt knepiga är signalbearbetningen efter sinnesintrycket. Här vet vi mindre om hur människan fungerar. Sinnesindelningen är oklar. En strikt fysiologisk beskrivning räcker inte för att till fullo förstå hur vi upplever lukt eller känner drag.

Tvärtom kan sådana modeller leda till dåliga apparater som lovar mer än de håller. Den elektroniska näsa som påstås känna lukter kan egentligen inte lukta, utan den kan bara känna igen en viss gasblandning – om det sedan är en hälsosam eller angenäm doft är en helt annan fråga. En s k termisk docka, gjord för att efterlikna människans temperaturkänslighet, kan inte känna om det är lagom varmt i en bil. Den kan ge uppgifter om att det blir varmare till vänster än till höger, men om det är komfortabelt eller inte kan dockan inte veta.

Rött är inte rött

Det är långtifrån säkert att mänskliga sinnesintryck är en förutsägbar och enkelriktad företeelse, dvs att gången är från sinnescell till hjärna och vidare till upplevelse. Perceptionspsykologer arbetar med teorin att vi formar våra sinnesupplevelser samtidigt som vi får dem. Hur vi upplever olika sinnesintryck är inte medfött. Samma stimuli kan ge olika förnimmelser hos olika individer. Rött är inte detsamma för dig som för mig – något som kanske inte förvånar.

Gränsen mellan vad som är information från sinnena och vad som är upplevelser, minnen, tänkande och fantasi blir därmed otydligare. Vilket i sin tur får till följd att gränsen flyttas för vad en robot utan intelligens och utan medvetande kan sägas klara.

För de allra flesta datorer är dock detta inte alls något problem. För dem är inte mänskliga sinnen något i sig att sträva efter. De vanligaste datorerna i dag sitter inbakade i t ex bilar, mikrovågsugnar, klockor, tv-apparater och tryckpressar. Det är högt specialiserade datorer som inte syns och som får data från omvärlden med speciella sensorer. I bilen finns t ex datorn som känner hjulens acceleration och därmed avgör om ett hjul slirar. I tryckpressen sitter en dator som känner av hur spänt papperet är.

Problemet uppstår när robotar ska kunna hantera mer allmänna situationer. Då räcker det inte med korta och enkla program som beskriver hur en mutter ser ut och hur hårt den ska dras åt. Roboten behöver en användbar omvärldsmodell. Den behöver veta hur världen är funtad, även utanför industrirobotens skräddarsydda miljö. Det räcker t ex inte att se perfekt om man inte alls vet vad det är man ser. Uppgiften att programmera in alla nödvändiga data om världen i roboten är en betungande uppgift – antingen måste allt hårdkodas i robotens minne eller också måste roboten kunna lära sig av sig själv.

Maskinerna behöver inte sinnen

De första automatiserade vävstolarna, jacquardmaskinerna från början av 1800-talet, styrdes med hålkort. På korten fanns uppgifter om vad som skulle vävas. Men även om kortläsaren gav data till vävstolen kan den knappast betraktas som ett sinne.

I dag arbetar många maskiner i realtid. Det betyder att maskinen hämtar information under tiden som den arbetar; den utför beräkningar direkt och lämnar resultat i tid så att de kan användas som input för nästa arbetsuppgift. Styrsystemet i JAS 39 Gripen är ett typiskt exempel. Datorerna i flygplanet måste beräkna hur klaffarna ska vinklas omedelbart efter pilotens instruktioner.

Det är först när maskinerna arbetar i realtid som de alls behöver något som liknar sinnen. Och det är bara till vissa speciella användningsområden som datorerna behöver sinnen som liknar människans. Människoliknande sinnen används i dag dels för att datorn bättre ska förstå en människas instruktioner, till exempel känna igen talade ord, dels när en robot ska röra sig i en vardaglig miljö. Självständiga servicerobotar och avancerade robotleksaker är två exempel där datorerna verkligen behöver flera av människans sinnen.

Robothundar spelar uselt

Sommaren 1999 hölls världsmästerskapen i robotfotboll i Stockholm. Flera olika typer av robotar, verkliga och simulerade, deltog. Det mest uppmärksammade spelet stod i klassen där små gulliga robothundar tävlade mot varandra. Men det var inte mellan hundarna som spelet var mest avancerat, snarare tvärt om. Hundarna, som säljs som leksaker för drygt 10 000 kronor styck, spelar usel fotboll.

Även i de andra klasserna hade robotarna uppenbara problem. Samspel saknades, alla som kunde var efter bollen och det blev många självmål. Betydligt mer förfinat var spelet i simuleringsklassen. Robotforskarna är uppdelade i två läger: de som jobbar med verkliga robotar och de som arbetar med simulerade robotar.

I simuleringsklassen tampades inte programmerarna med otydliga kamerabilder eller felande trycksensorer. Här idealiserades alla sinnesdata som skulle ge spelarna liv. Svårigheten låg i att skriva program som gav dem ett så smart fotbollsbeteende som möjligt. Trots att de som hade skapat de virtuella fotbollsmatcherna varit medvetet elaka och lagt in störningar och felaktigheter så att programmen inte kunde lita på alla data från de simulerade sinnena, blev spelet betydligt bättre.

Skillnaden mellan robothundarna och de simulerade fotbollspelarna visar att det spelar stor roll om man låter roboten känna verkligheten eller bara uppleva en virtuell värld.

De som utvecklar program till simulerade robotar menar att när robotsinnena är tillräckligt bra så har de programmen klappade och klara, medan de som skapar program för verkliga robotar med dagens bristfälliga sensorer menar att sinnena är så intimt förknippade med roboten att det inte går att simulera. Vem som har mest rätt återstår att se. Än så länge finns i alla fall de mänskliga sinnena bara hos människan och i någon mån i simulerarnas idealiserade värld.

Forskningen om artificiella sinnen Finansieras bl a av Stiftelsen för Strategisk Forskning, SSF, NUTEK, Teknikvetenskapliga Forskningsrådet, TFR och ett stort antal företag.