Så vinner AI människors tillit

Att kunna lita på en artificiell intelligens handlar inte bara om hur väl den presterar. Människan behöver också förstå tanken bakom dess beslut. Det visar en ny amerikansk studie.

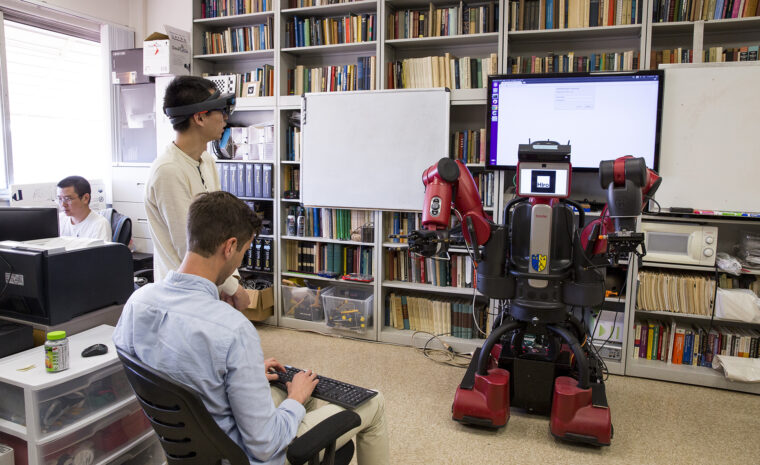

Bild: UCLA Samueli School of Engineering

AI-forskningen går framåt med stormsteg, men ligger efter när det gäller hur väl systemen kan förklara det de gör.

– Det är mycket mycket svårt att tolka det som händer inuti dagens deep learning-system, säger Mark Edmonds, forskare på institutionen för datavetenskap vid UCLA, Kalifornien.

Forskargruppen han tillhör har därför tagit fram en AI-modell som kan förklara sig, och samtidigt testat vilka typer av förklaringar som skapar mest tillit hos människor. Studien är publicerad i Science Robotics.

Stor variation trots samma prestation

Fem grupper om 30 personer fick se en robot öppna barnsäkra pillerburkar och fick samtidigt en förklaring till hur den gjorde för att lösa uppgiften. Robotens tillvägagångssätt var likadant varje gång men förklarades på olika sätt. Efteråt fick deltagarna bedöma hur mycket tillit de kände för robotens förmåga att öppna burkarna. Trots att den presterat exakt lika (en lyckad och en misslyckad öppning), varierade deltagarnas tillit stort.

Allra högst tillitspoäng fick roboten när den i realtid beskrev varje moment med ett ord och samtidigt visade sina rörelser på en animerad 3D-modell. När förklaringen kom i realtid med endast ord gavs i princip lika höga tillitspoäng.

En förklaringen med enbart 3D-modell gav dock inte alls lika höga tillitspoäng, trots att roboten visade vad som hände i realtid. Ännu sämre blev det när roboten enbart gav en textsammanfattning i efterhand – det gav tillitspoäng bara strax över att inte ge någon förklaring alls.

Resultaten tyder alltså på att en förklaring med hög tillit dels ska vara begriplig men även gå att hänga med i tidsmässigt – något Mark Edmonds och hans kollegor ska fortsätta undersöka.

Ska underlätta för ingenjörer

Trots att denna forskning på sikt kan bidra till AI som förklarar sig för konsumenter är det än så länge en avlägsen dröm. Forskningsfältet Explainable AI (XAI) är purfärskt och ska främst underlätta för ingenjörer. På så vis kan de fånga upp problem tidigare istället för att reda ut dem i efterhand, och minimera risken för obehagliga överraskningar – i värsta fall efter en olycka där någon blivit skadad.

– Just nu försöker vi bara lista ut hur vi kan göra dessa system mer förklarliga, och vad en bra förklaring är. Mindre fokus ligger på den långsiktiga tillämpningen, utan vi har börjat med detta första steg, säger Mark Edmonds.