”Universitetens nonchalans skrämmer mer än AI”

I februari kom den första fällningen av en student för använding av Chat GPT. Nu har den förbättrade versionen Chat GPT-4 släppts men universiteten har ännu inga riktlinjer för hur AI-verktyg ska hanteras. Det är dags att sluta blunda för utmaningen, skriver historikern Björn Lundberg.

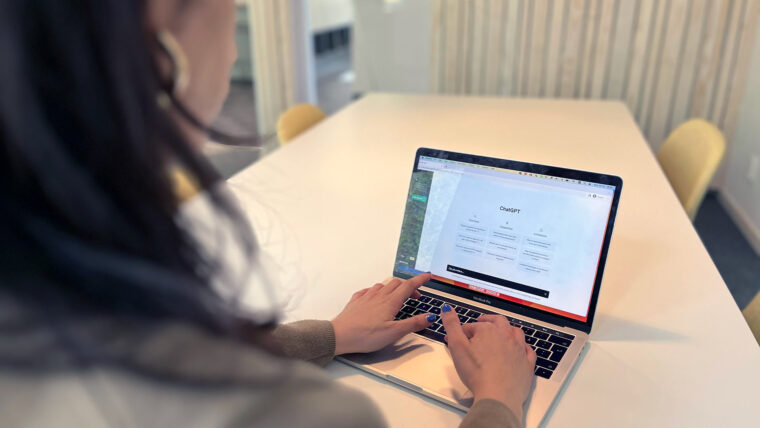

Många universitetslärare har inget begrepp om hur AI-applikationer som Chat GPT fungerar eller hur tentamensfrågor ska utformas för att minimera risken för fusk, menar historikern Björn Lundberg.

Bild: Getty images

Tre månader har gått sedan OpenAI lanserade Chat GPT, fick datorvärlden att häpna och sände chockvågor genom utbildningsväsendet. ”The college essay is dead” skrev tidningen The Atlantic. När applikationen var helt ny skrev jag ett inlägg med rubriken ”Jag har sett vad AI kan göra, och det är dags att bli rädd”. Alla talade plötsligt om Chat GPT, och sorlet har väl egentligen inte slutat.

Vad har jag lärt mig sedan dess? Är jag fortfarande rädd?

Tja, min text var tänkt som ett varningsrop – och det har väl i viss mån hörsammats. Diskussionen om hur AI-verktyg kan användas för fusk har tagit fart, men några tydliga riktlinjer eller regler har ännu inte tillkommit från universitetens sida. Problemet hanteras, som så ofta i trögrörliga strukturer, med försiktighet. Utbildningsminister Mats Persson har aviserat en utredning om cancelkultur, men om vi inte har en tydlig idé om hur AI kommer att påverka högre utbildning finns risken att vi cancellerar oss själva.

Lärare tar för lätt på problemet

På ett mer konkret plan är det fortfarande upp till enskilda lärare att utforma examinationsmomenten på sina universitetskurser (inom ramen för kursplanerna), och många har ännu inget som helst begrepp om hur dessa AI-applikationer fungerar eller hur vi kan formulera tentamensfrågor för att minimera risken för fusk.

Jag har talat med många lärare de senaste månaderna och reaktionerna är minst sagt spretiga. Jag skulle säga att nonchalansen bland vissa universitetslärare just nu skrämmer mig mer än AI-tekniken som sådan.

Ett alltför vanligt svar är: ”Jag tror inte det här är ett så stort problem”, vilket egentligen betyder: ”Jag vill inte att det här ska vara ett stort problem.”

En annan rätt vanlig reaktion är av typen: ”Jag testade Chat GPT men den svarade helt fel, så jag känner mig trygg med att studenter som använder den blir underkända.”

Det här är ett mycket svagt argument. Ja, eftersom Chat GPT gissar har den ofta fel, men det betyder inte att den alltid gissar fel. Om trettio studenter lämnar in AI-genererade svar och hälften blir underkända på grund av fel, så godkänner vi fortfarande hälften av fusksvaren – vilket vore oacceptabelt. Eftersom verktygen förfinas i rasande snabb takt kan vi inte heller räkna med att den kommer fortsätta svara fel nästa år, eller ens om två–tre månader.

Den här typen av undanflykter verkar intressant nog inte alls vara lika vanliga bland lärare på gymnasiet och högstadiet, som i allmänhet tycks vara mer införstådda med problemen och ta dem på stort allvar. Detta är åtminstone min bild, baserad på anekdotisk erfarenhet. Kanske är det så att universitetslärare har svårare att acceptera att de uppgifter studenterna ska utföra kan komma att ersättas av en dator? Att det vi ser som den finaste formen av lärande – abstrakt och självreflexivt tänkande – är det som Chat GPT i många fall är bäst på att emulera?

Testkör tentafrågorna i Chat GPT

Nu har OpenAI lanserat en ny version: Chat GPT-4, som bygger på den senaste versionen av språket. Enligt företaget är denna version en väsentlig förbättring, och den har bland annat förbättrat sina resultat på olika former av standardiserade tester jämfört med tidigare. Jag spår att utvecklingen kommer att gå fortsatt mycket snabbt, vilket innebär att de strategier universitetslärare utvecklar för att hantera problemet snabbt kan komma att bli daterade.

Till alla som arbetar med undervisning vill jag redan nu skicka med följande: blunda inte för denna utmaning. Testkör dina tentafrågor i Chat GPT och se hur svaren ser ut. Lita inte på att plagiatverktyg upptäcker maskinskapad text, särskilt inte på engelska. Det finns nämligen redan nu verktyg för att omformulera text för att få den att framstå som mer ”mänsklig”.

En tidigare version av artikeln har publicerats på BjörnLundbergsHistoria.

Björn Lundberg

- Björn Lundberg är fil. dr i historia och forskare vid Lunds universitet.

- Han disputerade 2018 med avhandlingen Naturliga medborgare: friluftsliv och medborgarfostran i scoutrörelsen och Unga Örnar 1925–1960.

- Nu forskar han om barns och ungas engagemang i internationella frågor under efterkrigstiden.

Prenumerera på Forskning & Framsteg!

10 tidningsnummer om året och dagliga nyheter på fof.se med kunskap baserad på vetenskap.